AWS-Rechnungen können am Black Friday schneller außer Kontrolle geraten als der Anwendungsverkehr. Doch die reflexartige Reaktion, bei der wahllos Ressourcen gekürzt werden, führt oft zu Leistungseinbußen, Kundenabwanderung und Technikteams, die sich bemühen, das Serviceniveau wiederherzustellen. Die eigentliche Herausforderung besteht nicht nur darin, die Kosten zu senken, sondern auch Ihre AWS-Ausgaben zu optimieren und gleichzeitig die Zuverlässigkeit und Leistung aufrechtzuerhalten, auf die Ihre Benutzer angewiesen sind. Unser DevOps-Dienste Das Team ist auf leistungsorientierte Cloud-Optimierung spezialisiert und hilft Entwicklungsteams dabei, Kostensenkungen von 20 bis 50% zu erzielen, ohne die Zuverlässigkeit oder das Benutzererlebnis zu beeinträchtigen.

Es ist wichtig zu beachten, dass AWS abgehalten hat 32% des globalen Infrastructure-as-a-Service-Marktes, wobei der Gesamtmarkt laut Statista auf rund 80 Milliarden US-Dollar geschätzt wird.

In diesem Handbuch wird ein leistungsorientierter Ansatz zur AWS-Kostenoptimierung vorgestellt, der auf Service Level Objectives (SLOs), Fehlerbudgets und bewährten technischen Verfahren basiert. Sie erfahren, wie Sie Ihre AWS-Rechnung durch datengestützte Entscheidungen, strukturelle Verbesserungen und Governance-Praktiken, die verhindern, dass Kostenschleichen zurückkehren, systematisch reduzieren können.

Ausgaben folgen der Architektur (nicht umgekehrt)

Bei den effektivsten AWS-Kostenoptimierungen geht es nicht darum, günstigere Services zu finden, sondern darum, Systeme zu entwickeln, die auf natürliche Weise weniger Ressourcen verbrauchen und gleichzeitig die Leistungsanforderungen erfüllen. Dieser architektonische Ansatz stellt sicher, dass sich die Kosteneinsparungen im Laufe der Zeit erhöhen, anstatt ständige Wachsamkeit zu erfordern.

Binden Sie Einsparungen an SLOs (Latenz, Verfügbarkeit) und Fehlerbudgets an

Bevor Sie mit einer AWS-Ressource in Berührung kommen, legen Sie klare Service Level Objectives für Ihre kritischen Benutzererfahrungen fest.

Wenn Ihre API beispielsweise innerhalb von 200 ms auf 99,9% der Anfragen antworten muss, wird dieses SLO zu Ihrer Leitplanke bei Optimierungsbemühungen. Jede Maßnahme zur Kosteneinsparung, bei der die Gefahr besteht, dass dieses SLO verletzt wird, sollte abgelehnt werden oder es sind zusätzliche Schutzmaßnahmen erforderlich.

Fehlerbudgets bieten den mathematischen Rahmen für die Abwägung von Kosten und Zuverlässigkeit. Wenn Sie ein SLO mit einer Verfügbarkeit von 99,9% haben, können Sie bis zu 43,8 Minuten Ausfallzeit pro Monat für Optimierungsexperimente, Infrastrukturänderungen oder akzeptable Serviceverschlechterungen „aufwenden“. Dieses Budget ermöglicht es Ihnen, kalkulierte Risiken bei Kostenoptimierungen einzugehen und gleichzeitig das Vertrauen Ihrer Kunden zu wahren.

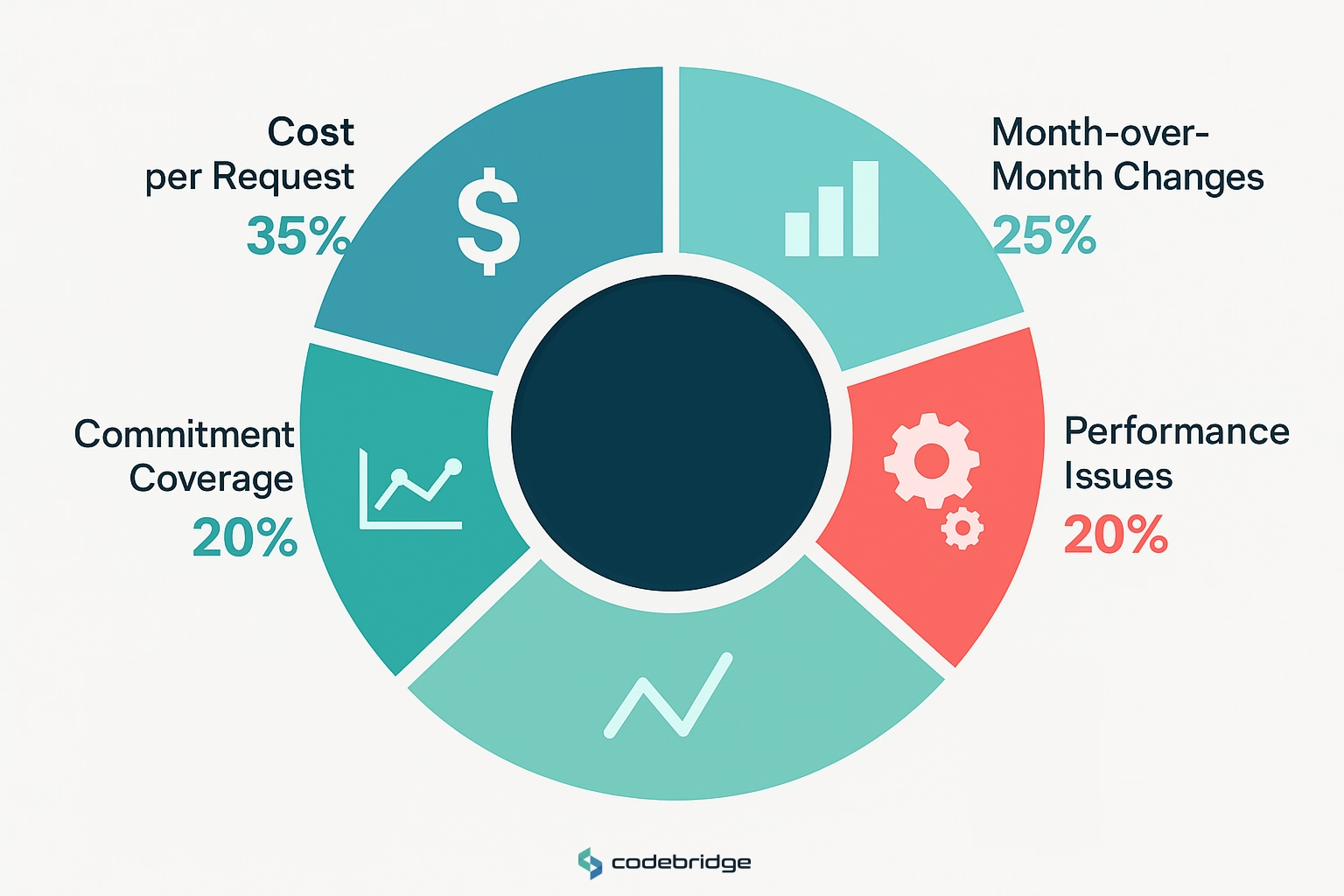

Kosten pro Anforderung/Benutzer als North-Star-Metrik; Beispiele für die Wirtschaftlichkeit von Einheiten

Die herkömmliche Kostenverfolgung konzentriert sich auf monatliche AWS-Rechnungen, aber die Wirtschaftlichkeit pro Einheit zeigt Optimierungsmöglichkeiten, die aggregierten Kennzahlen nicht bieten. Verfolgen Sie Kennzahlen wie:

- Kosten pro API-Anfrage: 0,002$ pro Anfrage mögen vernachlässigbar erscheinen, bis Sie feststellen, dass es 20.000$ für 10 Millionen monatliche Anfragen sind

- Kosten pro aktivem Benutzer: Eine SaaS-Plattform, die 2,50$ pro Monat pro aktivem Benutzer ausgibt, muss sicherstellen, dass der Kundenlebenswert diese Infrastrukturinvestition rechtfertigt

- Kosten pro Transaktion: E-Commerce-Plattformen sollten die Infrastrukturkosten anhand des Transaktionsvolumens abgleichen, um Ineffizienzen bei der Skalierung zu identifizieren

Diese Einheitenmetriken helfen Entwicklungsteams dabei, den direkten Zusammenhang zwischen Codeeffizienz, Architekturentscheidungen und Betriebswirtschaft zu verstehen. Eine Optimierung der Datenbankabfrage, die die RDS-CPU-Auslastung um 20% reduziert, führt direkt zu niedrigeren Kosten pro Anfrage und verbesserten Margen.

Was nicht gekürzt werden sollte (Beobachtbarkeit, Backups, Sicherheit)

Bei der Kostenoptimierung dürfen niemals drei grundlegende Bereiche beeinträchtigt werden:

Infrastruktur für Beobachtbarkeit bietet die Transparenz, die für eine effektive Optimierung erforderlich ist. Wenn Sie die Überwachungskosten senken, um ein paar hundert Dollar pro Monat einzusparen, können Leistungseinbußen, die Tausende an Umsatzeinbußen kosten, verschleiern. Investieren Sie in umfassende Protokollierung, Kennzahlen und Rückverfolgung. Der ROI durch schnellere Problembehebung und Optimierungsinformationen übersteigt bei weitem die Infrastrukturkosten.

Sicherungs- und Disaster-Recovery-Systeme stellen eine Versicherung gegen katastrophale Geschäftsverluste dar. Die Kosten für die Wartung automatisierter Backups, regionsübergreifender Replikation und Wiederherstellungstests verblassen im Vergleich zu den potenziellen Auswirkungen von Datenverlust oder längeren Ausfallzeiten.

Sicherheitskontrollen, einschließlich Verschlüsselung, Zugriffsmanagement und Compliance-Überwachung sind nicht verhandelbar. Sicherheitsverstöße können zu behördlichen Bußgeldern, Kundenabwanderung und Markenschäden führen, die potenzielle Einsparungen in der Infrastruktur in den Schatten stellen.

Zuerst die Messung, Ihre AWS-Kosten- und Leistungsbasis

Für eine effektive Optimierung müssen Sie Ihren aktuellen Zustand anhand präziser Messungen verstehen. Ohne Basiskennzahlen optimieren Sie blind und sind nicht in der Lage, Verbesserungen zu validieren oder Regressionen zu erkennen.

Kosten-Explorer und Kosten- und Nutzungsbericht (CUR), Tagging, Kostenzuweisung

AWS Cost Explorer bietet eine hohe Kostentransparenz, aber der Kosten- und Nutzungsbericht (CUR) liefert die granularen Daten, die für die Optimierung erforderlich sind. CUR exportiert stündliche Nutzungsdaten nach S3 und ermöglicht so eine detaillierte Analyse der Ausgabenmuster, der Ressourcenauslastung und der Kostenverteilung zwischen Teams und Diensten.

Implementieren Sie eine umfassende Tagging-Strategie, bevor Sie mit der Optimierung beginnen:

- Umwelt-Tags: Produktion, Inszenierung, Entwicklung, Test

- Team-/Besitzer-Tags: Welches Engineering-Team besitzt diese Ressource?

- Servicetags: Microservice oder Anwendungskomponente

- Kostenstellentags: Geschäftseinheit oder Projekt für Chargeback

- Lebenszyklus-Tags: Temporär, permanent, experimentell

Konsistentes Tagging ermöglicht eine genaue Kostenzuweisung und hilft bei der Identifizierung von Optimierungsmöglichkeiten. Eine Staging-Umgebung, die 40% Ihres RDS-Budgets verbraucht, deutet auf eine potenzielle Überversorgung oder vergessene Ressourcen hin.

AWS-Budgets und Anomalieerkennung; Warnungen, die Techniker tatsächlich lesen

Generische Budgetwarnungen, die das gesamte Engineering-Team per E-Mail über monatliche Überschreitungen informieren, sorgen für Übermüdung und werden ignoriert. Entwerfen Sie umsetzbare Warnmeldungen, die die richtigen Personen mit ausreichend Kontext erreichen, um sofort Maßnahmen ergreifen zu können:

- Servicespezifische Budgets: Informieren Sie das Team, das für die Lambda-Funktionen verantwortlich ist, wenn die Rechenkosten 110% des monatlichen Ziels überschreiten

- Schwellenwerte für die Erkennung von Anomalien: Konfigurieren Sie AWS Cost Anomaly Detection so, dass bei einem Tagesanstieg von 25% in bestimmten Servicekategorien eine Warnung ausgegeben wird

- Nutzungsbasierte Warnmeldungen: Löst Warnmeldungen aus, wenn die Kosten für die Datenübertragung darauf hindeuten, dass eine falsch konfigurierte Anwendung übermäßigen regionsübergreifenden Traffic generiert

Integrieren Sie Kostenwarnungen über Slack-Channels, PagerDuty oder Ticketsysteme, in denen Teams bereits bei betrieblichen Problemen zusammenarbeiten, in bestehende technische Arbeitsabläufe.

Compute Optimizer + Rightsizing Playbook (Sicherer Rollout)

AWS Compute Optimizer analysiert die Muster der Ressourcennutzung und empfiehlt die richtige Dimensionierung von Möglichkeiten. Rohempfehlungen müssen jedoch sorgfältig evaluiert und schrittweise eingeführt werden. Entwickeln Sie einen systematischen Ansatz:

Bewertungsphase: Lesen Sie die Compute Optimizer-Empfehlungen für Instances mit gleichbleibend niedriger Auslastung über einen Zeitraum von mehr als 14 Tagen. Prüfen Sie die Empfehlungen anhand der Anforderungen an die Anwendungsleistung und der Muster bei Spitzenauslastung.

Testphase: Implementieren Sie zuerst Änderungen in Nicht-Produktionsumgebungen und führen Sie Lasttests durch, um sicherzustellen, dass die Leistung auch bei kleineren Instance-Typen oder unterschiedlichen Konfigurationen akzeptabel ist.

Schrittweiser Rollout: Verwenden Sie für Produktionsänderungen blau-grüne Bereitstellungen oder fortlaufende Updates, um das Risiko zu minimieren. Überwachen Sie die wichtigsten Leistungsindikatoren während und nach der Umstellung kontinuierlich.

Rollback-Strategie: Behalten Sie die Möglichkeit bei, bei Leistungseinbußen schnell zu früheren Instanzkonfigurationen zurückzukehren. Dokumentieren Sie Rollback-Verfahren und stellen Sie sicher, dass Überwachungssysteme Leistungsprobleme innerhalb von Minuten erkennen können.

.png)

AWS-Kostensenkungsstrategien (Quick Wins im Vergleich zu strukturellen Änderungen)

Nicht alle Kostenoptimierungen erfordern den gleichen Aufwand oder bieten den gleichen langfristigen Wert. Die Kategorisierung von Chancen hilft dabei, Anstrengungen zu priorisieren und angemessene Erwartungen an den Zeitaufwand für die Entwicklung festzulegen. Schnelle Erfolge sorgen für sofortige Kostenentlastung und geben den Impuls für größere Optimierungsprojekte. Strukturelle Änderungen erfordern erhebliche technische Investitionen, führen aber zu nachhaltigen, langfristigen Einsparungen, die sich mit der Skalierung Ihrer Anwendung noch verstärken.

Compute & Scaling, der größte Hebel

Rechenressourcen machen in der Regel 40 bis 60% der AWS-Kosten aus und sind damit der Bereich, in dem Optimierungsmaßnahmen am stärksten betroffen sind. Rechenoptimierungen bergen jedoch auch das höchste Risiko einer Leistungsverschlechterung, wenn sie unachtsam implementiert werden.

EC2 Rightsizing-Schrittfrequenz (CPU/MEM/IO; Fallstricke zum Überwinden)

Richten Sie einen monatlichen Rightsizing-Überprüfungsprozess ein, der über einfache Kennzahlen zur CPU-Auslastung hinausgeht. Analysieren Sie Speicherauslastung, Festplatten-I/O-Muster und Netzwerkdurchsatz, um Optimierungsmöglichkeiten zu identifizieren:

Analyse der CPU-Auslastung: Suchen Sie nach Instances, die durchgehend unter 20% CPU-Auslastung laufen, aber stellen Sie sicher, dass eine niedrige Auslastung I/O-Engpässe oder Speicherbeschränkungen nicht maskiert, die bei kleineren Instance-Typen auftreten würden.

Speicheroptimierung: Speicheroptimierte Instances (R5, R6i) kosten deutlich mehr als Allzweck-Instances. Anwendungen, die weniger als 50% des verfügbaren Speichers nutzen, könnten von rechenoptimierten Instances mit einem höheren Verhältnis von CPU zu Speicher profitieren.

Fallstricke bei Burstable-Instanzen: T3/T4G-Instances bieten attraktive Grundpreise, aber Anwendungen, die die Basisleistung konstant übertreffen, verbrauchen CPU-Guthaben und können gedrosselt werden. Überwachen Sie das CPU-Guthaben und die Burst-Auslastung, um Workloads zu identifizieren, die sich besser für Instances mit fester Leistung eignen.

Sparpläne im Vergleich zu Reserved Instances (Deckungsziele, Flexibilität)

Beide verbindlichen Preismodelle bieten erhebliche Rabatte, bis zu 72% Rabatt auf On-Demand-Tarife, und Spot-Instances können Folgendes bieten Einsparungen von bis zu 90% für fehlertolerante Workloads (AWS). Die Wahl des richtigen Modells und der richtigen Deckungsstufe ist entscheidend, um zu vermeiden, dass unflexible oder unzureichende Kapazitätsreservierungen vorgenommen werden.

Deckungsziele: Mit Sparplänen sollten Sie eine Deckung Ihrer grundlegenden Rechenausgaben von 60-80% anstreben, sodass 20-40% als On-Demand-Kapazität für Skalierung und neue Workloads übrig bleiben. Dieses Gleichgewicht ermöglicht erhebliche Einsparungen und gewährleistet gleichzeitig die Flexibilität für Wachstum und Experimente.

Best Practices für Spot-Instances (Umgang mit Unterbrechungen, diversifizierte Pools)

Spot-Instances können die Rechenkosten um 50-90% senken, allerdings nur für Workloads, die Unterbrechungen problemlos bewältigen können. Eine erfolgreiche Einführung von Spot erfordert architektonische Änderungen und betriebliche Disziplin:

Diversifikationsstrategie: Verteilen Sie Spot-Anfragen auf mehrere Instance-Typen, Availability Zones und Spot-Pools, um die Wahrscheinlichkeit gleichzeitiger Unterbrechungen zu verringern, die sich auf Ihren gesamten Workload auswirken.

Umgang mit Unterbrechungen: Implementieren Sie reibungslose Verfahren zum Herunterfahren, die innerhalb der 2-minütigen Kündigungsfrist abgeschlossen werden können. Verwenden Sie Spot-Warnmeldungen bei Unterbrechungen, um Verbindungen abzubauen, Arbeiten während des Fluges abzuschließen und den Status vor der Kündigung aufrechtzuerhalten.

Fehlertolerante Architekturen: Entwerfen Sie Anwendungen, bei denen einzelne Instanzen verloren gehen können, ohne dass der Service beeinträchtigt wird. Verwenden Sie Autoscaling-Gruppen, Load Balancer und statusfreies Anwendungsdesign, um die Verfügbarkeit auch bei Spot-Unterbrechungen aufrechtzuerhalten.

Eignung für Arbeitslasten: Spot-Instances eignen sich am besten für Batchverarbeitung, CI/CD-Workloads, fehlertolerante Webanwendungen und Entwicklungsumgebungen. Vermeiden Sie die Verwendung von Spot für Datenbanken, Einzelinstanzanwendungen oder Workloads, für die eine garantierte Verfügbarkeit erforderlich ist.

Checkliste für den ROI und die Kompatibilität der Graviton-Migration

AWS Graviton-Prozessoren bieten ein 20-40% besseres Preis-Leistungs-Verhältnis als x86-Instances, aber die Migration erfordert eine sorgfältige Planung und Tests, um die Kompatibilität sicherzustellen:

Architekturkompatibilität: Die meisten modernen Anwendungen, die unter Linux laufen, unterstützen ARM64. Stellen Sie jedoch sicher, dass alle Abhängigkeiten, Container-Images und Bibliotheken von Drittanbietern ARM64-Versionen bereitstellen.

Leistungsvalidierung: Graviton-Prozessoren eignen sich hervorragend für Multithread-Workloads, können jedoch für Single-Thread-Rechenaufgaben oder spezielle Rechenaufgaben unterschiedliche Leistungsmerkmale aufweisen. Führen Sie vor der Migration gründliche Leistungstests durch.

Checkliste für die Migration:

- Prüfen Sie alle Anwendungsabhängigkeiten auf ARM64-Unterstützung

- Aktualisieren Sie CI/CD-Pipelines, um Container-Images mit mehreren Architekturen zu erstellen

- Testen Sie die Datenbankleistung und das Verhalten beim Verbindungspooling

- Validieren Sie die Kompatibilität von Überwachungs- und Observability-Tools

- Planen Sie eine schrittweise Migration, die mit unkritischen Workloads beginnt

Container und serverlos

Container- und serverlose Plattformen bieten im Vergleich zu herkömmlichen EC2-Bereitstellungen zusätzliche Optimierungsmöglichkeiten und sind komplexer. Diese verwalteten Services können den Betriebsaufwand reduzieren und gleichzeitig eine präzise Kostenkontrolle ermöglichen.

EKS-Kostenoptimierung (Knotengruppen, BinPacking, Karpenter, Cluster-Autoscaling)

Kubernetes-Workloads stellen aufgrund von Ressourcenanforderungen, Beschränkungen und Planungsineffizienzen einzigartige Herausforderungen bei der Kostenoptimierung dar. Eine effektive EKS-Optimierung erfordert Verbesserungen sowohl auf Clusterebene als auch auf Anwendungsebene:

Knotengruppenstrategie: Verwenden Sie mehrere Knotengruppen mit unterschiedlichen Instanztypen, um für unterschiedliche Workload-Anforderungen zu optimieren. CPU-intensive Anwendungen profitieren von rechenoptimierten Instances, während speicherintensive Workloads speicheroptimierte Knoten benötigen. Kombinieren Sie Spot- und On-Demand-Instances innerhalb von Knotengruppen auf der Grundlage der Workload-Fehlertoleranz.

Optimierung der Ressourcenanfrage: Viele Anwendungen stellen Ressourcenanforderungen auf der Grundlage von Spitzenanforderungen und nicht aufgrund der typischen Nutzung fest, was zu einer schlechten Cluster-Auslastung führt. Überprüfen Sie die CPU- und Speicheranforderungen anhand der tatsächlichen Nutzungsmuster und passen Sie die Anforderungen an, um das Bin-packing zu verbessern und gleichzeitig den Leistungsspielraum zu erhalten.

Adoption von Karpenter: Ersetzen Sie Cluster Autoscaler durch Karpenter für eine schnellere Skalierung und eine bessere Instanzauswahl. Karpenter kann innerhalb von Sekunden Knoten mit optimaler Größe bereitstellen und wählt automatisch die geeigneten Instanztypen auf der Grundlage der ausstehenden Pod-Anforderungen aus.

Vertikale Pod-Autoskalierung: Implementieren Sie VPA, um Ressourcenanforderungen automatisch an historische Nutzungsmuster anzupassen und so die Cluster-Auslastung ohne manuelles Eingreifen zu verbessern.

Fargate im Vergleich zu EC2 für Workloads (Kosten-/Leistungsschwellenwert)

Fargate macht den Aufwand für das Node-Management überflüssig, kostet aber 2- bis 4-mal mehr als die entsprechende EC2-Kapazität. Der Kosten-Nutzen-Schwellenwert hängt von den Nutzungsmustern und der betrieblichen Komplexität ab:

Vorteile von Fargate: Kein Node-Management, automatische Skalierung, vereinfachtes Sicherheitsmodell und Pay-per-Task-Preise eignen sich gut für ereignisgesteuerte Workloads, Batch-Jobs und Anwendungen mit unvorhersehbaren Datenverkehrsmustern.

Vorteile von EC2: Niedrigere Kosten pro CPU-/Speicherstunde, bessere Ressourcenauslastung durch Bin-Packing, Unterstützung für spezielle Instance-Typen und mehr Kontrolle über die zugrunde liegende Infrastruktur kommen stationären Workloads mit vorhersehbaren Ressourcenanforderungen zugute.

Entscheidungsrahmen: Verwenden Sie Fargate für Workloads mit einer Auslastung von unter 30% oder für die eine schnelle Skalierung von Null aus erforderlich ist. Verwenden Sie EC2-basierte Knotengruppen für stationäre Anwendungen mit gleichbleibenden Ressourcenanforderungen und einer Auslastung von über 50%

Lambda-Kostenoptimierung (Speicheroptimierung, Kaltstartstrategien, Parallelitätsgrenzen)

Die Lambda-Preisgestaltung basiert auf der Ausführungsdauer und dem zugewiesenen Speicher, weshalb die Speicheroptimierung für die Kostenkontrolle von entscheidender Bedeutung ist. Lambda weist die CPU-Leistung jedoch proportional zum Arbeitsspeicher zu, was zu komplexen Kompromissen bei der Optimierung führt:

Methode zur Speicheroptimierung: Testen Sie die Funktionsleistung bei Speicherzuweisungen von 128 MB bis 3008 MB, wobei sowohl die Ausführungsdauer als auch die Kosten pro Aufruf gemessen werden. Die optimale Speichereinstellung minimiert die Gesamtkosten (Dauer × Speicherzuweisung) und erfüllt gleichzeitig die Leistungsanforderungen.

Kaltstartoptimierung: Minimiert die Auswirkungen des Kaltstarts durch Bereitstellung von Parallelität für latenzempfindliche Funktionen, Verbindungspooling und Vermeidung schwerwiegender Abhängigkeiten im Initialisierungscode. Erwägen Sie containerbasierte Alternativen für Funktionen mit konstant hohen Kaltstarteinbußen.

Verwaltung der Parallelität: Legen Sie angemessene reservierte und bereitgestellte Parallelitätslimits fest, um zu verhindern, dass unerwartete Datenverkehrsspitzen oder Endlosschleifen außer Kontrolle geraten. Überwachen Sie gleichzeitige Ausführungen und Drosselungskennzahlen, um die Einstellungen für die Parallelität zu optimieren.

Speicher- und Datenlebenszyklus

Die Speicherkosten steigen im Laufe der Zeit stetig, da Anwendungen Protokolle, Backups und Benutzerdaten generieren. Durch die Implementierung eines intelligenten Lebenszyklusmanagements und die Auswahl geeigneter Speicherklassen können die langfristigen Speicherkosten erheblich gesenkt werden.

S3-Lebenszyklusrichtlinien und S3 Intelligent-Tiering (Protokolle, Backups, Data Lake)

Die S3-Speicherkosten können durch geeignete Lebenszyklusrichtlinien und die Auswahl der Speicherklasse um 30-70% gesenkt werden. Verschiedene Datentypen erfordern unterschiedliche Optimierungsstrategien:

Anwendungsprotokolle: Implementieren Sie Lebenszyklusrichtlinien, die Logs nach 30 Tagen auf Standard-IA, nach 90 Tagen auf Glacier Flexible Retrieval und nach 365 Tagen auf Glacier Deep Archive umstellen. Ziehen Sie Richtlinien zur Aufbewahrung von Protokollen in Betracht, die Protokolle automatisch löschen, sobald die Compliance-Anforderungen erfüllt sind.

Daten sichern: Verwenden Sie S3 Intelligent-Tiering für Backup-Daten mit unvorhersehbaren Zugriffsmustern. Aktivieren Sie die Stufe Deep Archive Access für die langfristige Aufbewahrung. Erwägen Sie die Komprimierung und Deduplizierung von Backups, um das Speichervolumen zu reduzieren.

Data Lake-Architekturen: Daten nach Datum und Zugriffshäufigkeit partitionieren. Verwenden Sie S3 Standard für aktuelle Monatsdaten, Standard-IA für aktuelle historische Daten und Glacier-Tiers für langfristige Analysedaten. Implementieren Sie ein abfragebasiertes Lebenszyklusmanagement, das die tatsächlichen Datenzugriffsmuster berücksichtigt.

Objektkomprimierung und S3 Select; Glacier Tiers; Replikationsfehler

Fortschrittliche S3-Optimierungstechniken können zu zusätzlichen Kosteneinsparungen führen, erfordern jedoch eine sorgfältige Implementierung, um Leistungs- oder Zuverlässigkeitsprobleme zu vermeiden:

Kompressionsstrategien: Ermöglichen Sie die serverseitige Komprimierung für textbasierte Inhalte (Logs, JSON, CSV), um das Speichervolumen und die Datenübertragungskosten zu reduzieren. Erwägen Sie vor dem Upload die clientseitige Komprimierung für große Binärdateien.

S3 Select Optimierung: Verwenden Sie S3 Select, um bestimmte Datenteilmengen abzurufen, anstatt ganze Objekte herunterzuladen. Dadurch werden die Datenübertragungskosten gesenkt und die Abfrageleistung für Analytics-Workloads verbessert.

Überlegungen zu Gletschern: Informieren Sie sich über die Mindestkosten für die Speicherdauer (90 Tage für Glacier Flexible Retrieval, 180 Tage für Deep Archive) und die Abrufkosten, bevor Sie die Glacier-Lifecycle-Richtlinien implementieren. Der häufige Zugriff auf in Glacier gespeicherte Daten kann die Standardspeicherkosten übersteigen.

Verwaltung der Replikationskosten: Die regionsübergreifende Replikation verdoppelt die Speicherkosten und erhöht die Datenübertragungskosten. Implementieren Sie selektive Replikationsregeln, die auf Geschäftsanforderungen basieren, anstatt ganze Buckets automatisch zu replizieren.

Datenbanken und Analysen

Mit der Skalierung der Anwendungen steigen die Datenbankkosten oft schneller als die Rechenkosten, weshalb die Datenbankoptimierung für ein langfristiges Kostenmanagement von entscheidender Bedeutung ist. Datenbankänderungen bergen jedoch ein höheres Risiko und erfordern eine sorgfältige Leistungsüberprüfung.

RDS-Kostenoptimierung (Instance-Familien, Speicher-Autoscaling, Read Replicas im Vergleich zum Caching)

Die RDS-Optimierung erfordert ein ausgewogenes Verhältnis von Kosten-, Leistungs- und Verfügbarkeitsanforderungen über mehrere Dimensionen hinweg:

Optimierung der Instanzfamilie: Moderne Instance-Familien (db.r6i, db.m6i) bieten ein besseres Preis-Leistungs-Verhältnis als frühere Generationen. Speicheroptimierte Instances kommen Workloads mit großen Datensätzen oder komplexen Abfragen zugute, während Allzweck-Instances gut für ausgewogene Workloads mit moderaten Speicheranforderungen geeignet sind.

Konfiguration für automatische Speicherskalierung: Aktivieren Sie die automatische Speicherskalierung, um eine Überbereitstellung zu verhindern, legen Sie jedoch maximale Speicherlimits fest, um zu verhindern, dass durch schlecht optimierte Abfragen oder Probleme mit der Datenspeicherung außer Kontrolle geratene Kosten entstehen. Überwachen Sie die Wachstumsmuster des Speichers, um Optimierungsmöglichkeiten zu identifizieren.

Replikat im Vergleich zu Caching-Strategie lesen: Read Replicas bieten letztendlich Konsistenz und volle SQL-Kompatibilität, verdoppeln aber die Datenbankkosten. Erwägen Sie die Implementierung von Caching auf Anwendungsebene (Redis, Memcached) für Daten, auf die häufig zugegriffen wird, bevor Sie Read Replicas hinzufügen. Verwenden Sie Read Replicas für analytische Workloads, die komplexe Abfragen statt einfacher Schlüsselwert-Lookups erfordern.

Aurora Serverless v2 Richtige Größe; Pause-/Fortsetzungsmuster

Aurora Serverless v2 bietet automatische Skalierung, erfordert jedoch eine sorgfältige Kapazitätskonfiguration, um Kosten und Leistung in Einklang zu bringen:

Minimale und maximale Kapazität: Stellen Sie die Mindestkapazität auf der Grundlage der Grundlast und nicht auf der Grundlage von Null ein, um Verzögerungen beim Kaltstart zu vermeiden. Konfigurieren Sie die maximale Kapazität konservativ, um Kostenspitzen aufgrund schlecht optimierter Abfragen oder Traffic-Anomalien zu vermeiden.

Skalierungsmuster: Aurora Serverless v2 skaliert schnell, aber nicht sofort. Anwendungen mit vorhersehbaren Datenverkehrsspitzen profitieren von geplanten Skalierungs- oder Vorwärmstrategien, die die Kapazität vor Spitzenzeiten erhöhen.

Optimierung pausieren/fortsetzen: Aurora Serverless v1 könnte bei Inaktivität pausieren, aber v2 behält immer die Mindestkapazität bei. Ziehen Sie Aurora Serverless v1 für Entwicklungs- und Testumgebungen mit intermittierenden Nutzungsmustern in Betracht.

DynamoDB On-Demand im Vergleich zu bereitgestellt; Autoscaling; DAX für Hotkeys

DynamoDB-Preismodelle erfordern das Verständnis der Zugriffsmuster und die Implementierung geeigneter Optimierungsstrategien:

Entscheidung auf Abruf im Vergleich zu bereitgestellter Entscheidung: On-Demand-Preise eignen sich gut für unvorhersehbare Workloads mit Nutzungsspitzen, kosten aber das 6-7-fache der bereitgestellten Kapazität für stationäre Workloads. Wechseln Sie zur bereitgestellten Kapazität, sobald die Datenverkehrsmuster vorhersehbar werden.

Auto Scaling-Konfiguration: DynamoDB Auto Scaling kann zur Optimierung der bereitgestellten Kapazität beitragen, reagiert aber langsam auf Verkehrsänderungen (5—15 Minuten). Konfigurieren Sie Skalierungsrichtlinien mit einer angemessenen Zielauslastung (70-80%) und Abklingzeiten, um Schwankungen zu vermeiden.

DAX-Caching-Strategie: DynamoDB Accelerator bietet eine Latenz von Mikrosekunden für Elemente, auf die häufig zugegriffen wird, erhöht jedoch mehr als 0,50 USD pro Stunde pro Cache-Knoten. Implementieren Sie DAX für leseintensive Workloads mit Hotkeys, die mehr als 10% der gesamten Lesekapazitätseinheiten ausmachen.

Rotverschiebung (Parallelitätsskalierung, RA3/Spektrum) und Warehouse-Schlafpläne

Die Data Warehouse-Kosten können durch die richtige Dimensionierung, Planung und architektonische Verbesserungen kontrolliert werden:

Verwaltung der Parallelität, Skalierung: Die Parallelitätsskalierung bietet eine automatische Skalierung für gleichzeitige Abfragen, berechnet jedoch On-Demand-Tarife. Überwachen Sie die Nutzung der Parallelitätsskalierung und ziehen Sie eine Erhöhung der Clustergröße in Betracht, wenn eine konsistente Skalierung darauf hindeutet, dass die Basiskapazität nicht ausreichend bereitgestellt wird

Bewertung von RA3 und DC2: RA3-Instances trennen Rechenleistung und Speicher, was eine unabhängige Skalierung und potenziell niedrigere Kosten für speicherintensive Workloads ermöglicht. Vergleichen Sie die Gesamtkosten einschließlich der Gebühren für Redshift Managed Storage mit den Preisen für DC2-Instances.

Automatisierte Terminplanung: Implementieren Sie automatische Pause-/Wiederaufnahmepläne für Entwicklungs- und Staging-Cluster. Produktionscluster können von einer Verkleinerung in Zeiten geringer Auslastung profitieren, wenn ETL-Prozesse entsprechend geplant werden können.

Netzwerk- und Datenübertragungskosten (oft übersehen)

Netzwerk- und Datenübertragungskosten werden häufig übersehen, bis sie 15 bis 25% der gesamten AWS-Ausgaben ausmachen. Diese Kosten erhöhen sich, wenn die Anwendungen wachsen und auf mehrere Dienste und Regionen verteilt werden.

Reduzierung des ausgehenden Datenausgangs über CloudFront; Origin Shield; Cache-Richtlinien

Der Datenausgang von AWS ins Internet kostet 0,09-0,15 USD pro GB, weshalb die CloudFront-Optimierung für inhaltsintensive Anwendungen von entscheidender Bedeutung ist:

CloudFront-Vertriebsstrategie: Platzieren Sie CloudFront-Distributionen vor allen öffentlich zugänglichen Inhalten, einschließlich API-Antworten, statischen Assets und herunterladbaren Dateien. Selbst dynamische Inhalte profitieren vom Edge-Caching gängiger Antworten und einer reduzierten Latenz.

Implementierung von Origin Shield: Aktivieren Sie Origin Shield in der AWS-Region, die Ihrem Ursprung am nächsten liegt, um Ursprungsanfragen und die damit verbundenen Datenübertragungskosten zu reduzieren. Origin Shield ist besonders effektiv für Ursprünge, die mehrere CloudFront-Distributionen bedienen.

Optimierung der Cache-Richtlinien: Implementieren Sie Cache-Richtlinien, die die Trefferquoten maximieren und gleichzeitig die Aktualität der Inhalte beibehalten. Verwenden Sie Cache-Schlüssel auf der Grundlage relevanter Anforderungsparameter und implementieren Sie geeignete Strategien zur Cache-Invalidierung für dynamische Inhalte.

NAT-Gateway-Ausgaben, VPC-Endpunkte, PrivateLink, Architekturkorrekturen

NAT-Gateways berechnen sowohl für die stündliche Nutzung (0,045 USD/Stunde) als auch für die Datenverarbeitung (0,045 USD/GB) eine Gebühr, was sie für Anwendungen mit hohem Datenverkehr teuer macht:

VPC-Endpunktimplementierung: Ersetzen Sie den NAT-Gateway-Verkehr zu AWS-Services durch VPC-Endpunkte. S3, DynamoDB, Lambda und andere AWS-Services unterstützen VPC-Endpunkte, wodurch die NAT-Gateway-Kosten für die Servicekommunikation entfallen.

PrivateLink-Optimierung: Verwenden Sie PrivateLink für die Kommunikation zwischen VPCs und mit Diensten von Drittanbietern, um Internet-Routing und die damit verbundenen NAT-Gateway-Kosten zu vermeiden. PrivateLink verbessert auch die Sicherheit und reduziert die Latenz.

Verbesserungen der Architektur: Prüfen Sie Anwendungsarchitekturen, die private Subnetze für den Zugriff auf Internetressourcen benötigen. Erwägen Sie, geeignete Workloads mit Sicherheitsgruppen für die Zugriffskontrolle in öffentliche Subnetze zu verlagern, sodass die NAT-Gateway-Anforderungen vollständig entfallen.

AZ-übergreifende Chatter- und Microservice-Kommunikation, Muster, die es zu reduzieren gilt

Die Datenübertragung in der Cros-Availability Zone kostet 0,01—0,02 $ pro GB in jede Richtung, was erhebliche Kosten für gesprächige Microservice-Architekturen verursacht:

Kollokation von Diensten: Stellen Sie nach Möglichkeit verwandte Microservices in derselben Availability Zone bereit und verwenden Sie Load Balancer-Integritätsprüfungen, um die Verfügbarkeit bei AZ-Ausfällen aufrechtzuerhalten. Nehmen Sie im Gegenzug für deutlich niedrigere Datenübertragungskosten eine leicht reduzierte Verfügbarkeit in Kauf.

Muster der Stapelverarbeitung: Ersetzen Sie häufige kleine API-Aufrufe zwischen Diensten durch Batch-Anfragen, die mehr Daten in weniger Vorgängen übertragen. Implementieren Sie asynchrone Nachrichtenmuster, die die Anforderungen an die Kommunikation in Echtzeit reduzieren.

Optimierung der Datenlokalität: Implementieren Sie Read Replicas und Caching-Strategien, die Daten aus derselben AZ bereitstellen wie verbrauchende Anwendungen. Verwenden Sie eventuell Konsistenzmodelle, die den Bedarf an synchroner Kommunikation zwischen den einzelnen AZ-Ländern reduzieren.

Leistungsleitplanken, die beweisen, dass Sie nichts kaputt gemacht haben

Kostenoptimierung ohne Leistungsvalidierung ist ein Rezept für Kundenauswirkungen und Imageschäden im technischen Bereich. Implementieren Sie eine umfassende Leistungsüberwachung und -tests, um sicherzustellen, dass Optimierungen die Benutzererfahrung nicht beeinträchtigen.

SLO/SLI-Tracking, Belastungstests, Kanaren; Rollback-Strategie

Richten Sie quantitative Leistungsbenchmarks ein, bevor Sie mit der Optimierung beginnen, und halten Sie diese Benchmarks während des gesamten Optimierungsprozesses ein:

SLO/SLI-Implementierung: Definieren Sie Service-Level-Indikatoren für kritische Benutzererfahrungen (API-Antwortzeit, Seitenladezeit, Transaktionserfolgsrate) und legen Sie Service Level Objectives fest, die die Erwartungen der Benutzer widerspiegeln. Verwenden Sie diese SLOs als Go-/No-Go-Kriterien für Optimierungs-Rollouts.

Kontinuierliche Belastungstests: Implementieren Sie automatisierte Lasttests, die vor und nach Optimierungsänderungen ausgeführt werden, und vergleichen Sie die Leistungsmerkmale unter verschiedenen Lastbedingungen. Verwenden Sie Tools wie k6, JMeter oder die AWS-Load Testing-Lösung, um die Leistung im großen Maßstab zu validieren.

Strategie für den Einsatz von Canary: Führen Sie Optimierungen schrittweise mithilfe von Canary-Bereitstellungen durch, bei denen ein kleiner Prozentsatz des Datenverkehrs einer optimierten Infrastruktur ausgesetzt ist und gleichzeitig wichtige Kennzahlen überwacht werden. Erweitern Sie Rollouts erst, nachdem überprüft wurde, dass die Leistungs-SLOs eingehalten werden.

Automatisierte Rollback-Systeme: Implementieren Sie automatische Rollback-Mechanismen, die durch SLO-Verstöße oder Leistungseinbußen ausgelöst werden. Definieren Sie klare Rollback-Kriterien und stellen Sie sicher, dass Rollback-Verfahren bei Vorfällen schnell ausgeführt werden können.

Leistungsbudgets in CI/CD; Kosten-/Leistungs-Dashboards pro Service

Integrieren Sie die Leistungs- und Kostenüberwachung in die Entwicklungsabläufe, um Regressionen zu verhindern und Optimierungsgewinne aufrechtzuerhalten:

CI/CD-Leistungsgatter: Implementieren Sie Leistungstests in CI/CD-Pipelines, bei denen Bereitstellungen fehlschlagen, wenn die Leistung über akzeptable Schwellenwerte hinaus abnimmt. Schließen Sie sowohl synthetische Leistungstests als auch Kostenprognosen auf der Grundlage der Ressourcenauslastung ein.

Dashboards auf Serviceebene: Erstellen Sie Dashboards, die Kosten- und Leistungskennzahlen für jeden Service miteinander in Beziehung setzen und die Kosten pro Anfrage, Antwortzeitperzentile, Fehlerraten und Ressourcenauslastung anzeigen. Machen Sie diese Dashboards für Entwicklungsteams sichtbar, um das Kostenbewusstsein zu wahren.

Leistungsbudgets: Legen Sie Leistungsbudgets fest, die die maximal akzeptablen Reaktionszeiten, die Ressourcenauslastung und die Kosten pro Anfrage für jeden Service festlegen. Behandeln Sie Budgetverstöße als technische Schuld, die sofortige Aufmerksamkeit erfordert.

FinOps und Unternehmensführung

Eine nachhaltige Kostenoptimierung erfordert organisatorische Prozesse, die Verantwortlichkeit des Teams und eine kontinuierliche Unternehmensführung, die verhindert, dass die Kosten nach Optimierungsbemühungen zurückkehren.

Tagging-Taxonomie (Env/Team/Service), Showback/Chargeback

Effektive Kostenzuweisung und Rechenschaftspflicht beginnen mit einer umfassenden und konsistenten Ressourcenkennzeichnung:

Standardisiertes Tagging-Schema: Implementieren Sie obligatorische Tags für Environment (Prod/Stage/Dev), Team (eigenes Engineering-Team), Service (Microservice oder Anwendung) und CostCenter (Geschäftseinheit). Verwenden Sie AWS Config Rules oder Tools von Drittanbietern, um die Einhaltung der Tagging-Richtlinien durchzusetzen.

Showback-Implementierung: Generieren Sie monatliche Kostenberichte, aus denen die AWS-Ausgaben jedes Teams, aufgeschlüsselt nach Service und Umgebung, ersichtlich sind. Machen Sie Kostentransparenz zu einem regelmäßigen Bestandteil der Team-Retrospektiven und Planungssitzungen, um das Kostenbewusstsein zu wahren.

Überlegungen zur Rückbuchung: Erwägen Sie die Implementierung von Chargebacks für Teams mit dedizierten AWS-Konten oder klaren Ressourcengrenzen. Vermeiden Sie Rückbuchungen für gemeinsam genutzte Dienste oder Infrastrukturen, von denen mehrere Teams profitieren, es sei denn, Sie können faire Zuweisungsmethoden festlegen.

Monatliche Sparzeremonien; Übernahme der Kosten durch die Techniker

Schaffen Sie organisatorische Rhythmen, die den Schwerpunkt auf die Kostenoptimierung legen, und feiern Sie Optimierungserfolge:

Sparzeremonien: Halten Sie monatliche Besprechungen ab, in denen Teams Optimierungsleistungen präsentieren, erfolgreiche Strategien austauschen und bevorstehende Optimierungsmöglichkeiten identifizieren. Identifizieren Sie Teams, die erhebliche Einsparungen erzielen und gleichzeitig die Leistungs-SLOs einhalten.

Übernahme der technischen Kosten: Weisen Sie den Entwicklungsteams die Verantwortung für die Kosten zu, anstatt sie als rein betriebliches Problem zu behandeln. Nehmen Sie Kostenkennzahlen in die Team-Dashboards auf und machen Sie die Kosteneffizienz zu einem Faktor bei Leistungsbeurteilungen und Beförderungskriterien.

Optimierungsrückstand: Pflegen Sie einen priorisierten Rückstand an Optimierungsmöglichkeiten, die durch Kostenanalysen, Leistungsüberwachung und Architekturüberprüfungen identifiziert wurden. Weisen Sie Optimierungsarbeiten dedizierte Entwicklungszeit zu, anstatt sie als Nebentätigkeit zu behandeln.

Abstimmung der Beschaffung: Festlegung der Deckungsrichtlinien (z. B. 60— 80%)

Passen Sie die Bemühungen zur Kostenoptimierung an die organisatorischen Beschaffungsprozesse und Engagement-Strategien an:

Entwicklung der Deckungspolitik: Richten Sie organisatorische Richtlinien für den Versicherungsschutz ein (Sparpläne, Reserved Instances), die Einsparungen und Flexibilität in Einklang bringen. Typische Policen zielen auf eine Deckung der Basisausgaben von 60 bis 80% ab, sodass Spielraum für Wachstum und Experimente bleibt.

Koordination der Beschaffung: Stimmen Sie sich mit den Beschaffungsteams bei verbindlichen Käufen, der jährlichen Budgetplanung und den Lieferantenverhandlungen ab. Teilen Sie die Ergebnisse der Kostenoptimierung mit, um Budgetbesprechungen zu unterstützen und die finanzielle Verantwortung des Entwicklungsteams unter Beweis zu stellen.

Risikomanagement: Entwickeln Sie Richtlinien für das Management von Bindungsrisiken, einschließlich Verfahren zur Änderung oder zum Verkauf ungenutzter Reservierungen und Strategien für den Umgang mit Überschreitungen der Verpflichtungen in Zeiten schnellen Wachstums.

30-60/90-Tage-AWS-Kostenoptimierungsplan

Eine systematische Kostenoptimierung erfordert einen schrittweisen Ansatz, der durch schnelle Erfolge für Dynamik sorgt und gleichzeitig strukturelle Verbesserungen vorbereitet, die zu langfristigen Einsparungen führen.

0—30 Tage: Tagging, CUR, Die 10 häufigsten Straftäter, schnelle Siege

Woche 1—2: Grundlage und Messung

- Implementieren Sie umfassendes Tagging für alle AWS-Ressourcen

- Konfigurieren Sie den Export von Kosten- und Nutzungsberichten (CUR) nach S3

- Richten Sie den AWS Cost Explorer mit den entsprechenden Filtern und Gruppierungen ein

- Identifizieren Sie die 10 wichtigsten Kostentreiber nach Service und Ressourcentyp

Woche 3-4: Implementierung von Quick Wins

- Löschen Sie ungenutzte EBS-Volumes, Snapshots und Load Balancer

- Aktualisieren Sie EBS-GP2-Volumes auf GP3, um sofort 20% Speicherplatz zu sparen

- Implementieren Sie grundlegende S3-Lebenszyklusrichtlinien für Protokolle und Backups

- Entfernen Sie inaktive EC2-Instances und nicht angehängte Elastic IP-Adressen

- Überprüfung und Optimierung von Datenübertragungsmustern, die hohe Ausgangskosten verursachen

Erwartete Ergebnisse: Sofortige Kostenreduzierung um 10-20%, festgelegter Messrahmen, Ausrichtung des Teams auf Optimierungsprioritäten.

31—60 Tage: Commit-Abdeckung, Rightsizing, S3-Lebenszyklus, NAT/VPC-Endpunkte

Woche 5-6: Engagement-Strategie

- Analysieren Sie historische Nutzungsmuster, um den optimalen Geltungsbereich der Sparpläne zu ermitteln

- Erwerben Sie Sparpläne, die auf 60 bis 70% der grundlegenden Rechenausgaben abzielen

- Beginnen Sie mit der systematischen EC2-Rightsizing auf der Grundlage der Empfehlungen von Compute Optimizer

- Implementieren Sie die Leistungsüberwachung für Instanzen mit der richtigen Größe

Woche 7-8: Architekturoptimierung

- Bereitstellen von VPC-Endpunkten für AWS-Services mit hohem Traffic (S3, DynamoDB, Lambda)

- Implementieren Sie umfassende S3-Lebenszyklusrichtlinien für alle Buckets

- Optimieren Sie die NAT-Gateway-Nutzung durch die Einführung von VPC-Endpunkten

- Beginnen Sie mit der EKS-Kostenoptimierung für containerisierte Workloads

Erwartete Ergebnisse: Zusätzliche Kostensenkung von 15 bis 25% durch Verpflichtungen und richtige Dimensionierung, verbesserte Architektureffizienz.

61—90 Tage: Graviton/Spot-Piloten, EKS-Skalierung, richtige Datenbankgröße

Woche 9-10: Erweiterte Rechenoptimierung

- Starten Sie das Graviton-Migrationspilotprogramm für geeignete Workloads

- Implementieren Sie die Einführung von Spot-Instances für fehlertolerante Anwendungen

- Stellen Sie Karpenter für EKS-Cluster bereit, um die Skalierungseffizienz zu verbessern

- Optimieren Sie die Lambda-Speicherzuweisung und die Parallelitätseinstellungen

Woche 11-12: Datenbank- und Speicheroptimierung

- Richtige Größe von RDS-Instances auf der Grundlage von Leistungsanalysen

- Implementieren Sie Aurora Serverless v2 für variable Workloads

- Optimieren Sie die DynamoDB-Kapazitätsmodi und implementieren Sie DAX-Caching

- Überprüfung und Optimierung von Data Lake-Speicher-Tiering-Strategien

Erwartete Ergebnisse: Zusätzliche Kostensenkung um 20-30% durch fortschrittliche Optimierungstechniken und etablierte Prozesse zur kontinuierlichen Optimierung.

Prozess der monatlichen Kostenüberprüfung:

- Generieren Sie Kostenberichte auf Serviceniveau mit einem Vergleich von Monat zu Monat

- Identifizieren Sie die 10 wichtigsten Kostensteigerungen und untersuchen Sie die Ursachen

- Lesen Sie die Empfehlungen von Compute Optimizer auf neue Möglichkeiten zur richtigen Dimensionierung

- Analysieren Sie ungenutzte Ressourcen (inaktive Load Balancer, nicht angehängte Volumes, gestoppte Instances)

- Validieren Sie die Nutzung der Verpflichtungen und identifizieren Sie Deckungslücken

- Überprüfen Sie die Datenübertragungskosten auf Optimierungsmöglichkeiten

- Aktualisieren Sie Kostenprognosen und Budgetwarnungen auf der Grundlage von Nutzungstrends

Grundlegende Kosten-Dashboards zum Erstellen:

- Dashboard für Führungskräfte: Monatliche Gesamtausgaben, Prognose, erzielte Einsparungen, Kosten pro Kunde/Anfrage

- Dashboard auf Serviceniveau: Aufschlüsselung der Kosten nach Microservice, Teamverantwortung, Aufteilung der Umgebung

- Dashboard zur Ressourcennutzung: CPU-/Speicherauslastung im Vergleich zu Kosten, Möglichkeiten zur richtigen Dimensionierung

- Dashboard zum Engagement: Sparpläne/RI-Nutzung, Prozentsatz der Abdeckung, bevorstehende Ablaufzeiten

- Anomalie-Dashboard: Kostenspitzen, ungewöhnliche Nutzungsmuster, Budgetschwellenverstöße

Wichtige Kennzahlen, die es zu verfolgen gilt:

- Kosten pro Anfrage/Transaktion/Benutzer (wirtschaftliche Einheit)

- Kostenänderungen gegenüber dem Vormonat je nach Service

- Umfang der Verpflichtungen und Nutzungsraten

- Perzentile zur Ressourcenauslastung (CPU, Arbeitsspeicher, Speicher)

- Einhaltung von Leistungs-SLOs bei Kostenoptimierungen

Fazit

Bei der AWS-Kostenoptimierung handelt es sich nicht um ein einmaliges Projekt, sondern um eine fortlaufende Praxis, die finanzielle Verantwortung mit operativer Exzellenz in Einklang bringt. Die in diesem Handbuch beschriebenen Strategien bieten einen Rahmen für systematische Kostensenkungen bei gleichzeitiger Aufrechterhaltung der Leistung und Zuverlässigkeit, die Ihre Kunden erwarten.

Der Schlüssel zu einer erfolgreichen Optimierung liegt in messungsgestützten Entscheidungen, Leistungsleitlinien und organisatorischen Prozessen, die verhindern, dass die Kosten zurückkehren. Beginnen Sie mit schnellen Erfolgen, um die Dynamik aufzubauen und Messsysteme zu etablieren, und gehen Sie dann zu strukturellen Verbesserungen über, die im Laufe der Zeit zu zusätzlichen Einsparungen führen.

Denken Sie an die Kernprinzipien:

- Architektur bestimmt das Ausgabenmuster mehr als die Serviceauswahl

- Leistungs-SLOs sind nicht verhandelbare Leitplanken für Optimierungsbemühungen

- Die Einheitsökonomie (Kosten pro Anfrage/Benutzer) zeigt Chancen auf, die aggregierten Kennzahlen nicht bieten

- Gehen Sie niemals Kompromisse bei Beobachtbarkeit, Backups oder Sicherheit ein, um Kosten zu senken

- Organisatorische Eigenverantwortung und Prozesse sorgen für nachhaltige Optimierungsgewinne

Der 30/60/90-Tage-Plan bietet einen praktischen Plan für eine systematische Optimierung, aber der AWS-Fußabdruck jedes Unternehmens bietet einzigartige Möglichkeiten und Einschränkungen. Berücksichtigen Sie bei der Priorisierung von Optimierungsmaßnahmen die Komplexität Ihrer Infrastruktur, Teamkapazität und Geschäftsanforderungen.

Sind Sie bereit, Ihre AWS-Kostenstruktur zu transformieren und gleichzeitig eine erstklassige Leistung aufrechtzuerhalten? Buche eine kostenlose Beratung um Ihre spezifischen AWS-Optimierungsmöglichkeiten zu besprechen und einen maßgeschneiderten Plan zu entwickeln, der Ihren Geschäftszielen und technischen Einschränkungen entspricht. Lassen Sie uns beweisen, dass sich Kosteneffizienz und herausragende Leistung nicht gegenseitig ausschließen, sondern ergänzende Aspekte gut strukturierter Systeme sind.

FAQ

Gibt es eine AWS-Checkliste zur Kostenoptimierung, die ich befolgen kann, ohne die Leistung zu beeinträchtigen?

Ja, nutze einen Performance-First-Flow: Definiere SLOs und Fehlerbudgets → Baseline mit CUR/Cost Explorer + obligatorisches Tagging → setze Budgets und Anomalieerkennung fest, die an die Servicebesitzer gebunden sind → wende Quick Wins an (gp2→gp3, S3-Lebenszyklus, ungenutzte LBS/Volumes löschen) → strukturierte Änderungen (Rightsizing über Compute Optimizer, Caching, Graviton/Spot-Piloten, Microservice und Netzwerkminimierung) → Durchsetzung von Leitplanken (Lasttests, Kanaren, Rollback) → füge FinOps-Governance (Showback/Chargeback, 60-80% ige Verpflichtungsdeckung) und monatliche „Sparzeremonien“ hinzu.

Wie führe ich eine AWS-Berechnung der Kosten pro Anfrage für meine API/SaaS durch?

Verfolgen Sie die Wirtschaftlichkeit pro Einheit (Kosten pro Anfrage/Benutzer/Transaktion). Beispiel: Wenn die Infrastrukturausgaben für 10 Mio. Anfragen 20.000$ betragen, betragen die Kosten pro Anfrage 0,002$und zielen Sie dann mithilfe von DB-Abfrage-Tuning, Caching und Rightsizing auf Reduzierungen ab, um CPU/RAM/I/O zu senken, und überprüfen Sie Verbesserungen vor dem Rollout anhand von Latenz-/Verfügbarkeits-SLOs.

Wie hoch ist der tatsächliche ROI der Graviton-Migration und wie validiere ich ihn?

Graviton liefert in der Regel ~20— 40% besseres Preis-Leistungsverhältnis, aber validieren: Überprüfen Sie die ARM64-Unterstützung, erstellen Sie Multiarch-Images, testen Sie Hotpaths auf Leistung, überprüfen Sie die Tool-/Observability-Kompatibilität und migrieren Sie dann schrittweise (unkritisch → Canary → Produktion) mit klarem Rollback.

Wann schlägt EKS-Kostenoptimierung Karpenter Cluster Autoscaler?

Karpenter verbessert das Bin-Packing und skaliert Knoten in Sekundenschnelle mit optimalen Instance-Optionen. Kombinieren Sie es mit Anforderungen/Limits in der richtigen Größe, mehreren Knotengruppen (Mix Spot/On-Demand) und (optional) VPA. Dadurch wird die Auslastung erhöht und gleichzeitig die p95-Latenz innerhalb der SLO-Budgets gehalten.

Sparpläne im Vergleich zu Reserved Instances 2025: Für welche sollte ich mich entscheiden?

Verwenden Sie Sparpläne für 60— 80% mit gleichbleibender Ausgangsbasis (breite Flexibilität über alle Dienste/Regionen hinweg) und RIs für hochgradig vorhersehbare, fixe Workloads. Stellen Sie 20— 40% On-Demand für Wachstum/Experimente ein; Layer Spot für fehlertolerante Aufgaben. Validieren Sie den Versicherungsschutz monatlich, um zu hohe Verpflichtungen zu vermeiden.

.avif)

.avif)