Softwareentwicklung ist zum Rückgrat moderner Geschäftsabläufe geworden, doch viele CEOs haben Schwierigkeiten zu verstehen, welche Kennzahlen für ihre technischen Investitionen wirklich wichtig sind.

Der globale Softwaremarkt wird auf geschätzt 730,7 Milliarden US-Dollar im Jahr 2024, voraussichtlich erreichen Laut Angaben von 1.397,3 Milliarden US-Dollar bis 2030 Grand View Forschungsprognose.

Während sich herkömmliche Geschäftskennzahlen auf Umsatz und Kosten konzentrieren, erfordern Softwaremetriken eine andere Sichtweise, eine, die Geschwindigkeit, Qualität und geschäftliche Auswirkungen in Einklang bringt. Für Unternehmen, die bereit sind, ihre technischen Messfunktionen zu transformieren, professionell kundenspezifische Softwareentwicklung Partnerschaften können das Fachwissen und die Unterstützung bei der Umsetzung bereitstellen, die für die Einrichtung erstklassiger Kennzahlprogramme erforderlich sind.

Dieser umfassende Leitfaden bietet Führungskräften den grundlegenden Rahmen für Kennzahlen, die sie benötigen, um datengestützte Entscheidungen über ihre technischen Organisationen zu treffen.

Warum Kennzahlen für CEOs wichtig sind (Klarheit, Kontrolle, Selbstvertrauen)

Die grundlegende Herausforderung für Führungsteams besteht darin, zwischen technischen Aktivitäten und Geschäftsergebnissen zu unterscheiden. Herkömmliche Kennzahlen wie geschriebene Codezeilen oder vervollständigte Storypoints geben kaum Aufschluss über die tatsächliche Wertschöpfung. Stattdessen benötigen CEOs Kennzahlen, die wichtige Geschäftsfragen beantworten: Stellen wir Funktionen bereit, die Kunden nutzen? Reduzieren unsere technischen Investitionen das Risiko oder schaffen wir es? Wie schnell können wir auf Marktchancen reagieren?

Moderne Softwaremetriken müssen die Lücke zwischen technischer Ausführung und Geschäftsstrategie schließen. Die effektivsten Kennzahlen erzählen eine Geschichte, die von der Produktivität einzelner Entwickler über die Effektivität des Teams bis hin zur Kundenwirkung reicht. Dies erfordert, dass nicht nur Eitelkeitskennzahlen berücksichtigt werden, sondern Messgrößen, die direkt mit der Unternehmensleistung, der Kundenzufriedenheit und dem Wettbewerbsvorteil korrelieren.

Abstimmung der technischen KPIs auf die Strategie (Umsatz, Marge, Risiko)

Technische KPIs werden zu strategischen Waffen, wenn sie richtig auf die Geschäftsziele abgestimmt sind. Umsatzausrichtung bedeutet, nachzuverfolgen, wie schnell das Engineering umsatzgenerierende Funktionen bereitstellen kann und wie oft diese Funktionen die tatsächliche Akzeptanz fördern. Bei Überlegungen zur Gewinnspanne ist es wichtig, die wahren Kosten der Funktionsentwicklung zu verstehen, einschließlich technischer Schulden und betrieblicher Gemeinkosten. Das Risikomanagement erfordert einen Überblick über Sicherheitslücken, die Systemzuverlässigkeit und die potenziellen Auswirkungen technischer Ausfälle auf das Geschäft.

Die erfolgreichsten Unternehmen stellen klare Verbindungen zwischen technischen Kennzahlen und Geschäftsergebnissen her. Diese Abstimmung ermöglicht fundierte Kompromisse zwischen Geschwindigkeit und Qualität, hilft bei der Priorisierung technischer Investitionen und stellt sicher, dass die technischen Bemühungen direkt den strategischen Zielen dienen, anstatt sich auf rein technische Kennzahlen zu konzentrieren.

Delivery Excellence: Die DORA-Metriken, die CEOs wissen müssen

Das DevOps Research and Assessment (DORA) -Team hat vier wichtige Kennzahlen identifiziert, die durchweg mit leistungsstarken Ingenieurorganisationen korrelieren. Diese Kennzahlen, die durch mehr als ein Jahrzehnt an Untersuchungen in Tausenden von Organisationen gestützt werden, bilden die Grundlage für die Messung der Leistung bei der Softwarebereitstellung.

Vorlaufzeit für Änderungen (Definition, Formel, Datenquelle, Ziele)

Definition: Lead Time for Changes misst die Zeit vom Code-Commit bis zur Produktionsbereitstellung. Diese Kennzahl erfasst die Effizienz Ihrer gesamten Softwarebereitstellungspipeline und gibt an, wie schnell Ihr Unternehmen auf Marktchancen oder Kundenbedürfnisse reagieren kann.

Formel: Vorlaufzeit = Bereitstellungszeit für die Produktion — Zeit der ersten Bereitstellung

Quelle der Daten: Versionskontrollsysteme (GitHub, GitLab) in Kombination mit CI/CD-Pipeline-Tools (Jenkins, CircleCI) liefern die Zeitstempel, die für eine genaue Berechnung erforderlich sind.

Gesunde Sortimente:

.png)

- Elite: Weniger als 1 Stunde

- Hoch: Zwischen 1 Tag und 1 Woche

- Mittel: Zwischen 1 Woche und 1 Monat

- Niedrig: Zwischen 1 Monat und 6 Monaten

Bereitstellungshäufigkeit (Schrittfrequenz nach Produkttyp)

Definition: Die Bereitstellungshäufigkeit misst, wie oft Codeänderungen erfolgreich in der Produktion implementiert werden. Eine höhere Häufigkeit deutet in der Regel auf ausgereiftere Entwicklungsprozesse und ein geringeres Bereitstellungsrisiko hin.

Berechnung: Bereitstellungshäufigkeit = Gesamtzahl der Bereitstellungen/Zeitraum

Branchen-Benchmarks nach Produkttyp:

- Web-Anwendungen: Mehrmals täglich (Elite-Teams)

- Mobile Anwendungen: Wöchentlich bis monatlich (aufgrund von Überprüfungsverfahren im App Store)

- Unternehmenssoftware: Wöchentlich bis zweiwöchentlich

- Regulierte Branchen: Monatlich bis vierteljährlich (Compliance-Anforderungen)

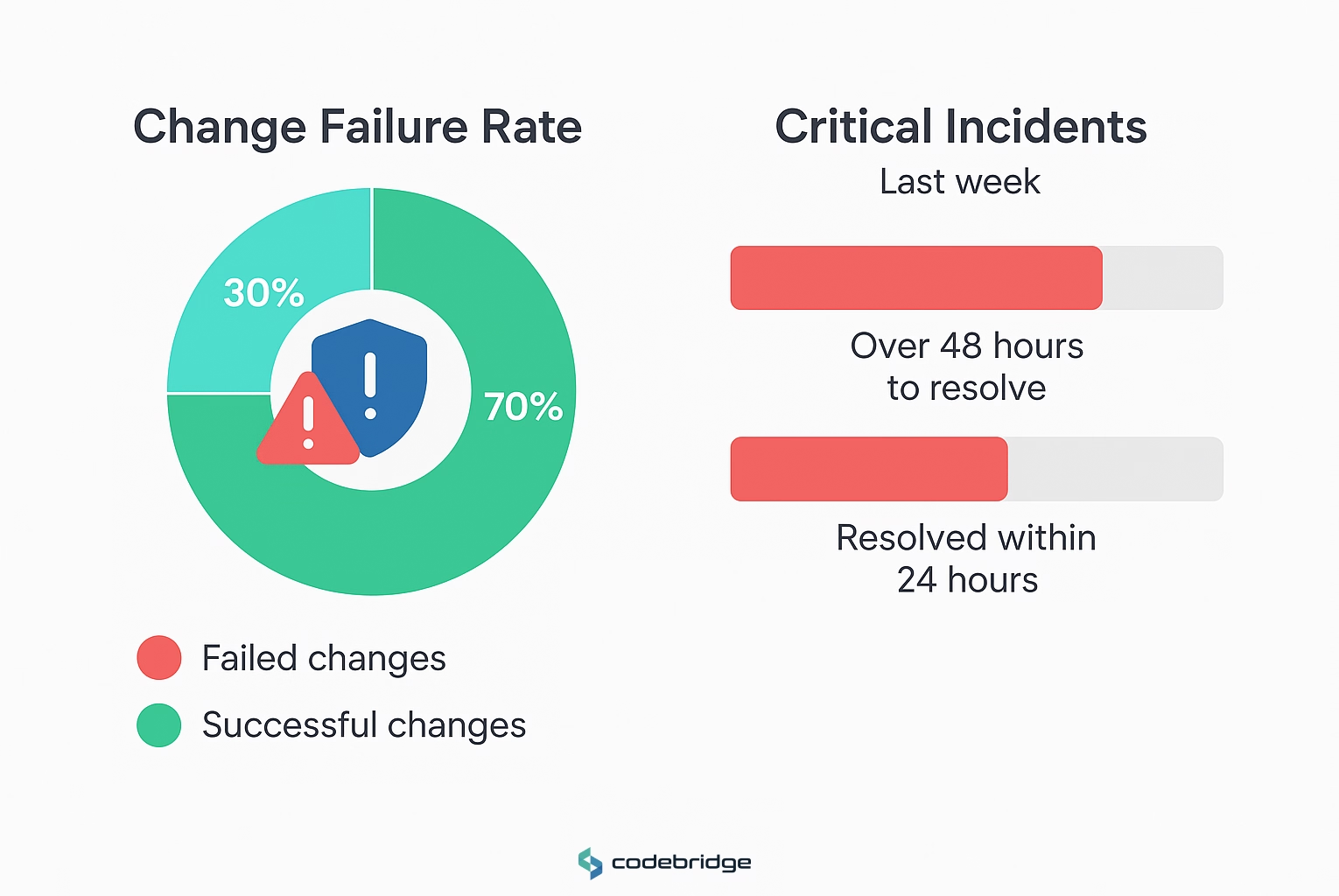

Ausfallrate ändern (Defekte/Vorfälle pro Bereitstellung)

Definition: Die Änderungsausfallrate gibt den Prozentsatz der Bereitstellungen an, die zu Produktionsausfällen führen, die eine sofortige Behebung erfordern.

Formel: Ausfallrate ändern = (Fehlgeschlagene Bereitstellungen/Gesamtzahl der Bereitstellungen) × 100

Zielbereiche:

- Elite: 0-15%

- Hoch: 16-30%

- Mittel: 16-30%

- Niedrig: 46-60%

MTTR (Wiederherstellen oder Auflösen, Paging-Disziplin)

Die Mean Time to Restore (MTTR) misst, wie schnell sich Teams nach Produktionsausfällen erholen können. Diese Metrik unterscheidet zwischen Erkennungszeit, Lösungszeit und vollständiger Wiederherstellung und gibt Aufschluss über die Effektivität der Reaktion auf Vorfälle.

Berechnungsmethoden:

- Zeit zum Erkennen: Das Überwachungssystem warnt vor menschlicher Bestätigung

- Zeit zur Lösung: Beginn des Vorfalls bis zur Beseitigung der Ursache

- Zeit zum Wiederherstellen: Leistungsverschlechterung bis Wiederherstellung der vollen Funktionalität

Zielbereiche:

- Elite: Weniger als 1 Stunde

- Hoch: Weniger als 1 Tag

- Mittel: Zwischen 1 Tag und 1 Woche

- Niedrig: Zwischen 1 Woche und 1 Monat

.png)

Ablauf und Planung: Softwaretechnik-Metriken, die über DORA hinausgehen

Die Zykluszeit bietet detaillierte Einblicke in die Effizienz von Entwicklungsabläufen, indem die Gesamtzeit von der Arbeitsaufnahme bis zur Produktionsbereitstellung gemessen wird. Wenn man die Aufteilung zwischen Wartezeit (Wartezeit) und Bearbeitungszeit (aktive Arbeit) versteht, werden Engpässe und Optimierungsmöglichkeiten aufgedeckt.

Komponenten der Zykluszeit:

- Zeit der Codierung: Erster Commit zur Erstellung von Pull-Requests

- Uhrzeit der Abholung: PR-Erstellung bis zur ersten Bewertung

- Zeitpunkt der Überprüfung: Beginn der Überprüfung bis zur Genehmigung

- Bereitstellungszeit: Zur Produktionsversion zusammenführen

Branchen-Benchmarks:

- Elite-Teams: Unter 26 Stunden Gesamtzykluszeit

- Teams, die verbessert werden müssen: Über 167 Stunden

Die wichtigste Erkenntnis ist, dass kürzere Zykluszeiten mit einer höheren Codequalität korrelieren, da längere Entwicklungszyklen die Wahrscheinlichkeit von Konflikten und veralteten Abhängigkeiten erhöhen.

Durchsatz und WIP (Little's Law; WIP-Grenzwerte)

Little's Law (Throughput = WIP/Cycle Time) bietet einen mathematischen Rahmen für die Optimierung des Entwicklungsflusses. Diese Beziehung zeigt, dass die Reduzierung von Work-in-Progress (WIP) und der Zykluszeit den Gesamtdurchsatz erhöht, ohne dass zusätzliche Ressourcen erforderlich sind.

Vorteile des WIP-Managements:

- Reduzierter Aufwand beim Kontextwechsel

- Konzentrieren Sie sich stärker auf die Fertigstellung als auf den Beginn neuer Arbeiten

- Früheres Feedback und schnellere Fehlererkennung

- Vorhersagbarere Lieferpläne

PR-Größe und Prüfungszeit (Auswirkung auf Qualität/Geschwindigkeit)

Die Größe von Pull-Requests wirkt sich direkt auf die Qualität der Bewertungen und die allgemeine Entwicklungsgeschwindigkeit aus. Untersuchungen zeigen durchweg, dass kleinere PRs gründlicher geprüft werden, weniger Fehler enthalten und schneller zusammengeführt werden als große Änderungen.

Richtlinien zur optimalen PR-Größe:

- Ziel: Unter 200 Codezeilen geändert

- Elite-Teams: Unter 85 Zeilen geändert

- Schwellenwert für Probleme: Über 400 Zeilen (schlechte Bewertungsqualität)

Auswirkung auf die Geschwindigkeit: Kleine PRs durchlaufen die Entwicklungspipeline bis zu fünfmal schneller als große PRs und bieten eine deutlich bessere Überprüfungsqualität und niedrigere Fehlerraten.

Prognosegenauigkeit und Zuverlässigkeit der Roadmap (probabilistische Bereitstellung)

Präzise Prognosen ermöglichen eine bessere Geschäftsplanung und das Vertrauen der Stakeholder. Moderne Prognoseansätze verwenden historische Zykluszeitdaten, um wahrscheinlichkeitstheoretische Schätzungen zu liefern, anstatt deterministische Zusagen zu treffen.

Die wichtigsten Komponenten:

- Historische Zykluszeitverteilungen

- Schätzung der Arbeitskomplexität

- Konfidenzintervalle für Liefertermine

- Regelmäßige Messung und Verbesserung der Prognosegenauigkeit

Schutz des Kundenerlebnisses

Die Escaped Defect Rate misst den Prozentsatz der Fehler, die trotz Testaufwand in die Produktion gelangen. Diese Kennzahl gibt direkt Aufschluss über die Effektivität der Qualitätssicherungsprozesse und wirkt sich auf die Kundenzufriedenheit aus.

Formel: Rate ausgebliebener Fehler = (Produktionsdefekte/Gesamtzahl der Fehler) × 100

Industriestandards:

- Ziel: Unter 5%

- Akzeptabel: 5-10%

- Muss verbessert werden: Über 10%

Beispiel für eine Berechnung: Wenn von insgesamt 100 festgestellten Mängeln 20 Fehler in die Produktion gelangen, liegt die Fluchtquote bei 20%.

Absturzfreie Metriken bieten direkte Einblicke in die Anwendungsstabilität und das Nutzererlebnis. Diese Metriken werden als Aggregationen im Zeitverlauf berechnet, nicht als Durchschnittswerte, weshalb sie für das Verständnis der Nutzerauswirkungen besonders wertvoll sind.

Benchmarks für Mobilgeräte:

- Akzeptabel: 99,95% absturzfreie Sitzungen, 99% absturzfreie Nutzer

- Median der Branche: 99,94% absturzfreie Sitzungen

- Ziel für große Apps: 99,99% + absturzfreie Benutzer

Überlegungen zur Webanwendung: Web-Apps weisen aufgrund der Browservielfalt und der Netzwerkbedingungen in der Regel andere Muster auf als mobile Apps.

Verfügbarkeit, SLO und Fehlerbudget (Kompromisse mit Geschwindigkeit)

Service Level Objectives (SLOs) definieren eine akzeptable Serviceleistung, während Fehlerbudgets die zulässige Unzuverlässigkeit quantifizieren. Dieses Framework ermöglicht datengestützte Kompromisse zwischen der Geschwindigkeit der Funktionen und der Systemstabilität.

Fehler bei der Budgetberechnung:

- SLO: 99,9% Verfügbarkeit über 30 Tage

- Fehlerbudget: 0,1% = 43,2 Minuten Ausfallzeit pro Monat

- Richtlinie: Stoppen Sie die Veröffentlichung von Funktionen, wenn das Budget erschöpft ist

Kompromissentscheidungen:

- Budget verfügbar: Konzentrieren Sie sich auf Geschwindigkeit und Innovation der Funktionen

- Niedriges Budget: Betonen Sie Stabilitäts- und Zuverlässigkeitsverbesserungen

- Budget erschöpft: Releases einfrieren, bis die Zuverlässigkeit wiederhergestellt ist

Leistungskennzahlen (p50/p95 Latenz, Core Web Vitals)

Leistungskennzahlen wirken sich direkt auf die Benutzererfahrung und die Geschäftsergebnisse aus. Wichtige Leistungsindikatoren sollten sich auf die vom Nutzer wahrgenommene Leistung konzentrieren und nicht auf rein technische Kennzahlen.

Essentielle Kennzahlen:

- p50 Latenz: Mittlere Reaktionszeit (typische Benutzererfahrung)

- p95 Latenz: Reaktionszeit im 95. Perzentil (schlechteste akzeptable Erfahrung)

- Core Web Vitals: Googles Kennzahlen zur Nutzererfahrung für Webanwendungen

- Durchsatz: Anfragen, die pro Zeiteinheit unter Last bearbeitet werden

Risikotransparenz für den Vorstand

Schwachstellenrückstand und SLA-Einhaltung (kritisch/hoch/mittelschwer)

Das Management von Sicherheitslücken erfordert klare SLAs und eine konsistente Nachverfolgung, um sicherzustellen, dass kritische Risiken umgehend behoben werden. Verschiedene Schweregrade der Sicherheitslücken erfordern unterschiedliche Reaktionszeiten.

Standard-SLAs:

- Kritische Sicherheitslücken: 24-48 Stunden

- Sicherheitslücken mit hohem Risiko: 30 Tage

- Sicherheitslücken mit mittlerem Risiko: 60 Tage

- Sicherheitslücken mit geringem Risiko: 90 Tage

Wichtige Kennzahlen:

- SLA-Konformitätsrate nach Schweregrad

- Durchschnittliche Zeit bis zur Problembehebung

- Alterung der Sicherheitslücke (Tage seit Offenlegung)

- Trends bei der Größe des Rückstands nach Risikoniveau

Aktualität der Abhängigkeiten (SBOM, Aktualisierungsrhythmus)

Moderne Anwendungen sind stark auf Abhängigkeiten von Drittanbietern angewiesen, weshalb das Abhängigkeitsmanagement zu einem kritischen Sicherheitsproblem wird. Die Nachverfolgung der Softwarelisten (SBOM) und regelmäßige Updates reduzieren Sicherheitsrisiken und technische Schulden.

Komponenten verfolgen:

- Alter der Abhängigkeiten (Tage seit der letzten Version)

- Anzahl der bekannten Sicherheitslücken in aktuellen Versionen

- Aktualisierungshäufigkeit und Erfolgsquote

- Identifizierung und Überwachung kritischer Abhängigkeiten

Verfügbarkeit, SLO und Fehlerbudget (Kompromisse mit Geschwindigkeit)

Service Level Objectives (SLOs) definieren eine akzeptable Serviceleistung, während Fehlerbudgets die zulässige Unzuverlässigkeit quantifizieren. Dieses Framework ermöglicht datengestützte Kompromisse zwischen der Geschwindigkeit der Funktionen und der Systemstabilität.

Fehler bei der Budgetberechnung:

- SLO: 99,9% Verfügbarkeit über 30 Tage

- Fehlerbudget: 0,1% = 43,2 Minuten Ausfallzeit pro Monat

- Richtlinie: Stoppen Sie die Veröffentlichung von Funktionen, wenn das Budget erschöpft ist

Kompromissentscheidungen:

- Budget verfügbar: Konzentrieren Sie sich auf Geschwindigkeit und Innovation der Funktionen

- Niedriges Budget: Betonen Sie Stabilitäts- und Zuverlässigkeitsverbesserungen

- Budget erschöpft: Releases einfrieren, bis die Zuverlässigkeit wiederhergestellt ist

Leistungskennzahlen (p50/p95 Latenz, Core Web Vitals)

Leistungskennzahlen wirken sich direkt auf die Benutzererfahrung und die Geschäftsergebnisse aus. Wichtige Leistungsindikatoren sollten sich auf die vom Nutzer wahrgenommene Leistung konzentrieren und nicht auf rein technische Kennzahlen.

Essentielle Kennzahlen:

- p50 Latenz: Mittlere Reaktionszeit (typische Benutzererfahrung)

- p95 Latenz: Reaktionszeit im 95. Perzentil (schlechteste akzeptable Erfahrung)

- Core Web Vitals: Googles Kennzahlen zur Nutzererfahrung für Webanwendungen

- Durchsatz: Anfragen, die pro Zeiteinheit unter Last bearbeitet werden

Risikotransparenz für den Vorstand

Das Management von Sicherheitslücken erfordert klare SLAs und eine konsistente Nachverfolgung, um sicherzustellen, dass kritische Risiken umgehend behoben werden. Verschiedene Schweregrade der Sicherheitslücken erfordern unterschiedliche Reaktionszeiten.

Standard-SLAs:

- Kritische Sicherheitslücken: 24-48 Stunden

- Sicherheitslücken mit hohem Risiko: 30 Tage

- Sicherheitslücken mit mittlerem Risiko: 60 Tage

- Sicherheitslücken mit geringem Risiko: 90 Tage

Wichtige Kennzahlen:

- SLA-Konformitätsrate nach Schweregrad

- Durchschnittliche Zeit bis zur Problembehebung

- Alterung der Sicherheitslücke (Tage seit Offenlegung)

- Trends bei der Größe des Rückstands nach Risikoniveau

Aktualität der Abhängigkeiten (SBOM, Aktualisierungsrhythmus)

Moderne Anwendungen sind stark auf Abhängigkeiten von Drittanbietern angewiesen, weshalb das Abhängigkeitsmanagement zu einem kritischen Sicherheitsproblem wird. Die Nachverfolgung der Softwarelisten (SBOM) und regelmäßige Updates reduzieren Sicherheitsrisiken und technische Schulden.

Komponenten verfolgen:

- Alter der Abhängigkeiten (Tage seit der letzten Version)

- Anzahl der bekannten Sicherheitslücken in aktuellen Versionen

- Aktualisierungshäufigkeit und Erfolgsquote

- Identifizierung und Überwachung kritischer Abhängigkeiten

Audit-Trail-Abdeckung und Zugriffsprüfungen (SOX/ISO/SOC2-Angleichung)

Die Compliance-Anforderungen erfordern umfassende Prüfprotokolle und regelmäßige Zugriffsprüfungen. Diese Kennzahlen belegen Auditoren und Vorstandsmitgliedern die Effektivität der Unternehmensführung.

Unverzichtbare Versorgungsbereiche:

- Workflows zur Nachverfolgung und Genehmigung von Codeänderungen

- Protokollierung und Überwachung des Produktionszugriffs

- Ergebnisse automatisierter Konformitätsprüfungen

- Zugriff auf Abschlussquoten und Ergebnisse von Prüfungen

Kosten pro Funktion/Ergebnis (Zuordnung, Fallstricke)

Wenn Sie die wahren Kosten der Funktionsentwicklung verstehen, können Sie bessere Entscheidungen zur Priorisierung und Ressourcenzuweisung treffen. Eine genaue Kostenzuweisung erfordert jedoch eine sorgfältige Methodik, um irreführende Schlussfolgerungen zu vermeiden.

Allokationsansätze:

- Direkte Entwicklungszeit und Ressourcen

- Proportionale Infrastruktur- und Werkzeugkosten

- Qualitätssicherungs- und Testaufwand

- Fortlaufende Wartungs- und Supportanforderungen

Häufige Fallstricke:

- Ignorieren der gemeinsamen Infrastrukturkosten

- Unterschätzung des langfristigen Wartungsaufwands

- Nichtberücksichtigung der technischen Schuldenakkumulation

- Zu starke Vereinfachung komplexer Feature-Interdependenzen

Cloud-Kosten pro Anfrage/Benutzer (FinOps-Ansicht)

Die Wirtschaftlichkeit von Cloud-Einheiten bietet Einblicke in die Betriebseffizienz und die Skalierungsmerkmale. Das Verständnis der Kosten pro Einheit ermöglicht fundierte Entscheidungen über Architektur und Kapazitätsplanung.

Wichtige Einheitenkennzahlen:

- Kosten pro Anfrage: Gesamtsumme der Cloud-Ausgaben/API-Anfragen

- Kosten pro Nutzer: Infrastrukturkosten/aktive Nutzer

- Kosten pro Transaktion: Bearbeitungskosten/Geschäftsvorfälle

- Nutzung der Ressourcen: Tatsächliche Nutzung/ bereitgestellte Kapazität

Reifegrade:

- Krabbeln: Cloud-Ausgaben als Prozentsatz des Umsatzes

- Gehen: API-Aufruf oder Transaktionskosten

- Lauf: Kosten pro umsatzgenerierender Aktivität

Build/Run Split, Plattform-ROI, Zinsen für technische Schulden

Das Gleichgewicht zwischen der Entwicklung neuer Funktionen und der Wartung vorhandener Systeme wirkt sich direkt auf die langfristige Nachhaltigkeit des Unternehmens aus. Plattforminvestitionen und technisches Schuldenmanagement erfordern eine sorgfältige Messung und Kommunikation.

Analyse erstellen/ausführen:

- Prozentsatz der Entwicklungszeit für neue Funktionen im Vergleich zur Wartung

- ROI von Plattforminvestitionen durch Produktivitätssteigerungen der Entwickler

- „Zinsen“ aus technischen Schulden als laufender Wartungsaufwand

- Auswirkungen der Infrastrukturautomatisierung auf die Betriebskosten

Beweisen, dass Software das Unternehmen bewegt

Time to Value (TTV) misst, wie schnell Benutzer signifikante Vorteile aus neuen Funktionen oder Produkten ziehen. Diese Kennzahl korreliert direkt mit der Nutzerbindung und den Auswirkungen auf das Geschäft.

TTV-Berechnung:

- Definition: Zeit von der ersten Benutzerinteraktion bis zum ersten aussagekräftigen Ergebnis

- Messung: Melden Sie sich für den Abschluss der Schlüsselaktion an

- Optimierung: Reduzieren Sie Barrieren und verbessern Sie den Onboarding-Flow

- Validierung: A/B-Tests verschiedener Nutzerreisen

Branchenmuster:

- SaaS-Produkte: Minuten bis Tage für den Anfangswert

- Komplexe Unternehmenstools: Tage bis Wochen bis zur vollständigen Einführung

- Entwicklertools: Stunden bis zum ersten erfolgreichen Anwendungsfall

Anpassung der Funktionen, Retention, Lifting, Deflection (Unterstützung)

Kennzahlen zur Einführung von Funktionen zeigen, welche Investitionen den tatsächlichen Nutzernutzen und die Geschäftsergebnisse beeinflussen. Das Verständnis der Akzeptanzmuster ermöglicht eine bessere Produktpriorisierung und Ressourcenzuweisung.

Wichtige Kennzahlen zur Akzeptanz:

- Akzeptanzrate von Funktionen: (Feature-Benutzer/Benutzer insgesamt) × 100

- Zeit für eine Adoption: Tage von der Veröffentlichung der Funktion bis zur ersten Verwendung

- Adoptionstiefe: Häufigkeit und Umfang der Nutzung von Funktionen

- Auswirkungen auf die Kundenbindung: Nutzerbindung vor/nach der Einführung von Funktionen

Messung der Auswirkungen auf das Geschäft:

- Reduzierung des Support-Ticketvolumens durch Self-Service-Funktionen

- Steigerung der Nutzerbindung durch neue Funktionen

- Korrelation zwischen Umsatz und Nutzungsrate von Funktionen

CSAT/NPS für ausgelieferte Funktionen (Qualitätssignal)

Kundenzufriedenheitskennzahlen für bestimmte Funktionen geben direktes Feedback zur Effektivität von Produktinvestitionen. Umfragen zur Zufriedenheit nach der Veröffentlichung ermöglichen eine schnelle Wiederholung und Verbesserung.

Messansätze:

- CAST: Zufriedenheit mit Interaktionen mit bestimmten Funktionen

- NPS: Wahrscheinlichkeit einer Weiterempfehlung aufgrund der Erfahrung mit den Funktionen

- Funktionsspezifische Umfragen: Gezieltes Feedback zu neuen Funktionen

- Nutzungskorrelation: Zufriedenheitswerte im Vergleich zur tatsächlichen Nutzung der Funktionen

Best Practices für die Implementierung:

- Zeitpunkt der Umfrage: Kurz nach der Interaktion mit dem Feature

- Optimierung der Rücklaufquote: Kurze, kontextbezogene Umfragen

- Trendanalyse: Verfolgen Sie Veränderungen der Zufriedenheit im Laufe der Zeit

- Maßnahmenplanung: Klarer Prozess zur Bearbeitung von Feedback

Zufriedenheit und Fokuszeit (Makertime im Vergleich zu Besprechungen)

Die Zufriedenheit der Entwickler steht in direktem Zusammenhang mit Produktivität, Kundenbindung und Codequalität. Das SPACE-Framework betont die Zufriedenheit als Frühindikator für zukünftige Leistungsherausforderungen.

Die wichtigsten Zufriedenheitstreiber:

- Sinnvolle Arbeit: Ausrichtung auf persönliche und Unternehmensziele

- Autonomie: Entscheidungskompetenz und Flexibilität bei der Werkzeugwahl

- Meisterschaft: Lernmöglichkeiten und Kompetenzentwicklung

- Work-Life-Balance: Nachhaltiges Tempo und flexible Arrangements

Fokuszeitmessung:

- Ununterbrochene Codierungsblöcke (mindestens 2-4 Stunden)

- Erfüllung von Dichte- und Verteilungsmustern

- Häufigkeit und Auswirkung des Kontextwechsels

- Zeitbalance zwischen tiefgründiger Arbeit und Zusammenarbeit

Signale zur Zusammenarbeit (Teilnahme überprüfen, Übergaben)

Effektive Zusammenarbeit steigert die Teamleistung und sorgt gleichzeitig für die individuelle Produktivität. Die Messung der Zusammenarbeit erfordert sowohl quantitative Aktivitätskennzahlen als auch eine qualitative Bewertung der Interaktion.

Metriken zur Zusammenarbeit:

- Teilnahme am Code-Review: Verhältnis von abgegebenen/erhaltenen Bewertungen

- Teilen von Wissen: Dokumentationsbeiträge und Peer-Helping

- Teamübergreifende Kommunikation: Teamübergreifende Projektteilnahme

- Mentoring-Aktivitäten: Unterstützung und Beratung für Junior-Entwickler

Gesunde Muster der Zusammenarbeit:

- Verteilte Teilnahme an Reviews (nicht auf wenige Personen konzentriert)

- Rechtzeitiges Feedback zur Bewertung (innerhalb von 24-48 Stunden)

- Konstruktive Feedback-Qualität und Hilfsbereitschaft

- Wissensverteilung zwischen den Teammitgliedern

Aktivität ≈ Ergebnisse (Warum Codezeilen/Storypoints irreführen)

Herkömmliche Aktivitätskennzahlen wie Codezeilen und Story Points erfassen nicht die tatsächliche Produktivität und können zu kontraproduktiven Verhaltensweisen führen. Moderne Produktivitätsmessungen konzentrieren sich eher auf Ergebnisse und Auswirkungen als auf das Produktionsvolumen.

Warum Aktivitätskennzahlen irreführend sind:

- Codezeilen: Prämiert ausführliche Lösungen gegenüber eleganten

- Story-Punkte: Gamification führt im Laufe der Zeit zu Punktinflation

- Häufigkeit festlegen: Ermutigt zu bedeutungslosen Commits zur Optimierung von Kennzahlen

- Arbeitsstunden: Verbindet die aufgewendete Zeit mit dem gelieferten Wert

Ergebnisorientierte Alternativen:

- Effektivität und Qualitätsfeedback zur Codeüberprüfung

- Fertigstellung von Funktionen und Messung der Geschäftsauswirkungen

- Problemlösungsgeschwindigkeit und Lösungseleganz

- Kundenzufriedenheit mit den bereitgestellten Funktionen

Das Executive Software KPI-Dashboard (Vorlage)

Dashboards für Führungskräfte müssen ein ausgewogenes Verhältnis zwischen umfassender Berichterstattung und umsetzbaren Erkenntnissen bieten. Die effektivsten Dashboards präsentieren Informationen zu angemessenen Zeitskalen und konzentrieren sich auf Kennzahlen, die strategische Entscheidungen ermöglichen.

Wöchentliches Dashboard (operativer Schwerpunkt):

Häufigkeit der Bereitstellung: Geschwindigkeitstrends veröffentlichen

Ausfallrate ändern: Qualitäts- und Stabilitätsindikatoren

Kritische Vorfälle: Produktionsprobleme und Lösungszeiten

Fortschritt im Sprint: Liefersicherheit der aktuellen Iteration

Sicherheitswarnungen: Schwachstellenstatus mit hoher Priorität

Zufriedenheit des Teams: Glücks- und Besorgniserregende Signale der Entwickler

Schwellenwerte und Trendpfeile in Rot/Bernstein/Grün

Klare visuelle Indikatoren ermöglichen eine schnelle Entscheidungsfindung der Geschäftsleitung, ohne dass ein tiefer technischer Kontext erforderlich ist. Schwellenwerte sollten auf der historischen Leistung, branchenspezifischen Benchmarks und der Risikotoleranz von Unternehmen basieren.

Rahmenwerk für Statusindikatoren:

- Grün: Die Leistung erfüllt oder übertrifft die Ziele, positive Trends

- Bernstein: Die Leistung ist akzeptabel, zeigt aber besorgniserregende Trends

- Rot: Leistung unter den Schwellenwerten, sofortige Aufmerksamkeit erforderlich

- Trendpfeile: 30-Tages-Richtungsanzeiger unabhängig vom absoluten Status

Benchmarks nach Produkttyp (B2B-SaaS, Verbraucher, reguliert)

Die Benchmarks zur Softwareleistung unterscheiden sich je nach Branche, Produkttyp und organisatorischem Kontext erheblich. Das Verständnis dieser Unterschiede verhindert unangemessene Vergleiche und setzt realistische Verbesserungsziele.

B2B-SaaS-Benchmarks:

- Häufigkeit der Bereitstellung: Tägliche bis wöchentliche Veröffentlichungen

- Vorlaufzeit: 1—7 Tage für die meisten Änderungen

- Ausfallrate ändern: 10-20% akzeptabel

- Übernahme von Funktionen: 30-50% innerhalb des ersten Monats

Anwendungen für Verbraucher:

- Häufigkeit der Bereitstellung: Mehrere tägliche Veröffentlichungen

- Absturzfreie Benutzer: 99.95% + erforderlich

- Aufführung: Reaktionszeiten unter einer Sekunde sind kritisch

- Übernahme von Funktionen: 15-40% typischer Bereich

Regulierte Branchen:

- Häufigkeit der Bereitstellung: Wöchentliche bis monatliche Zyklen

- Dokumentation ändern: 100% ige Konformität erforderlich

- Reaktion auf die Sicherheit: 24-Stunden-SLAs für kritische Probleme

- Audit-Trail: Vollständige Änderungsverfolgung erforderlich

Wie setzt man sich Ziele (Perzentilzüge, Quartilsprünge)

Effektive Zielsetzung bringt Ehrgeiz und Realismus in Einklang und verwendet historische Leistungsdaten, um erreichbare, aber bedeutsame Verbesserungen zu ermitteln. Auf Perzentilen beruhende Ziele bieten klarere Ziele als willkürliche prozentuale Verbesserungen.

Rahmen für die Zielsetzung:

- Analyse des aktuellen Zustands: Legen Sie die Ausgangsleistung für alle Kennzahlen fest

- Perzentilbewertung: Ermitteln Sie das aktuelle Leistungsperzentil im Vergleich zur Branche

- Auswahl des Ziels: Streben Sie eine Verbesserung des nächsten Quartils über einen Zeitraum von 6-12 Monaten an

- Planung von Meilensteinen: Teilen Sie große Verbesserungen in erreichbare Schritte auf

Beispiel für eine Zielstruktur:

- Aktuell: Bereitstellungshäufigkeit im 70. Perzentil (wöchentliche Veröffentlichungen)

- Ziel: Bereitstellungshäufigkeit im 85. Perzentil (tägliche Veröffentlichungen)

- Zeitleiste: 6-monatiger Verbesserungsplan mit monatlichen Checkpoints

- Investition: Werkzeuge, Schulungen und Prozessverbesserungen erforderlich

Antimuster und metrisches Spielen (Goodhart's Law)

Goodhart's Law besagt: „Wenn ein Maß zu einem Ziel wird, ist es kein gutes Maß mehr.“ Um die Integrität des Messsystems aufrechtzuerhalten und kontraproduktives Verhalten zu vermeiden, ist es unerlässlich, das Spielen von Metriken zu verstehen und zu verhindern.

Allgemeine Spielmuster:

- Einsatz: Frequenz: Gaming: Bedeutungslose Zusagen, Zahlen in die Höhe zu treiben

- Lead Time Gaming: Einfache Änderungen für die Messung auswählen

- Storypoint Gaming: Schätzungen überhöhen, um produktiver zu erscheinen

- Testabdeckung Gaming: Tests schreiben, die die Funktionalität nicht überprüfen

Präventionsstrategien:

- Balanced Scorecards: Verwenden Sie mehrere verwandte Metriken, um das Spielen zu verhindern

- Qualitative Bewertungen: Regelmäßige Bewertung quantitativer Daten durch den Menschen

- Metrische Drehung: Ändern Sie regelmäßig bestimmte Maße und behalten Sie dabei die Absicht bei

- Kultureller Fokus: Betonen Sie Lernen und Verbessern vor Zielerreichung

So implementieren Sie dies in 30/60/90 Tagen

0—30: Gerätedaten, Glossar definieren, Dashboard wählen

Der erste Monat konzentriert sich auf die Schaffung von Messgrundlagen, ohne Teams zu überfordern oder vorzeitige Optimierungsentscheidungen zu treffen.

Woche 1-2: Bewertung und Planung

- Prüfen Sie vorhandene Tools und Datenquellen

- Befragen Sie wichtige Interessengruppen zu aktuellen Problembereichen

- Definieren Sie das erste Metrikglossar mit klaren Definitionen

- Identifizieren Sie sofortige Datenerfassungslücken

Woche 3-4: Grundlegende Instrumentierung

- Konfigurieren Sie die Überwachung der Bereitstellungshäufigkeit über CI/CD

- Richten Sie anhand der Versionskontrolle eine Durchlaufzeitmessung ein

- Richten Sie die grundlegende Vorfallverfolgung und MTTR-Berechnung ein

- Erstellen Sie ein einfaches Dashboard mit 3 bis 5 Kernmetriken

31—60: Baseline + Ziele setzen, Ritual überprüfen, Engpass beheben

Im zweiten Monat stehen die Festlegung von Basiswerten, die Festlegung realistischer Ziele und der Beginn von Verbesserungsinitiativen auf der Grundlage von Dateneinblicken im Mittelpunkt.

Woche 5-6: Festlegung der Ausgangslage

- Erfassung konsistenter Metrikdaten für 4-6 Wochen

- Aktuelle Leistungsperzentile berechnen

- Identifizieren Sie die drei wichtigsten Verbesserungsmöglichkeiten

- Legen Sie vorläufige Ziele für den 90-Tage-Horizont fest

Woche 7-8: Prozess und rituelle Schöpfung

- Wöchentliche Treffen zur Überprüfung der Kennzahlen einrichten

- Erstellen Sie monatliche Management-Dashboard-Berichte

- Definieren Sie Eskalationsverfahren für metrische Schwellenwerte

- Beginnen Sie mit der Behebung des festgestellten Engpasses mit den größten Auswirkungen

61—90: Automatisieren Sie Benachrichtigungen, verknüpfen Sie Kennzahlen mit Anreizen und Planung

Der letzte Monat konzentriert sich auf die Einbettung von Kennzahlen in organisatorische Prozesse und die Sicherstellung einer nachhaltigen langfristigen Verbesserung.

Woche 9-10: Automatisierung und Integration

- Implementieren Sie automatische Warnmeldungen für kritische Metrik-Schwellenwerte

- Integrieren Sie Kennzahlen in die Sprint-Planung und Roadmap-Diskussionen

- Verbinden Sie Leistungsdaten mit Team-Retrospektiven und Verbesserungsplanungen

- Einrichtung eines vierteljährlichen Verfahrens zur Überprüfung der Kennzahlen und zur Anpassung der Ziele

Woche 11-12: Ausrichtung von Kultur und Anreizen

- Verknüpfen Sie Teamziele mit wichtigen Leistungskennzahlen

- Richten Sie Anerkennungsprogramme für Verbesserungen der Kennzahlen ein

- Erstellen Sie monatliche Herausforderungen zur Verbesserung der Kennzahlen

- Beginnen Sie im zweiten Quartal mit der Planung der Einführung erweiterter Kennzahlen

Tools und Datenquellen

Moderne Kennzahlen für die Softwareentwicklung erfordern eine Datenintegration über mehrere Werkzeugkategorien hinweg. Jeder Werkzeugtyp liefert spezifische Daten, die für umfassende Messungen unerlässlich sind.

Versionskontrollsysteme (GitHub, GitLab, Bitbucket):

- Zeitstempel und Autoreninformationen eintragen

- Erstellung, Überprüfung und Zusammenführung von Daten durch Pull-Requests

- Lebensdauer der Filiale und Zeiten für die Lösung von Zusammenführungskonflikten

- Teilnahme- und Qualitätskennzahlen für Code-Reviews

CI/CD-Pipeline-Tools (Jenkins-, CircleCI-, GitHub-Aktionen):

- Bereitstellungshäufigkeit und Erfolgsraten

- Bauzeit, Trends und Fehleranalysen

- Ausfall der Dauer der Pipeline-Phase

- Bereitstellungs-Rollback- und Ausfallwiederherstellungsdaten

Problemverfolgung (Jira, Linear, Azure DevOps):

- Zykluszeiten und Durchsatz der Arbeitselemente

- Sprint-Burndown- und Geschwindigkeitsberechnungen

- Fehlererstellung und -behebungsverfolgung

- Analyse des Zeitplans für die Bereitstellung von Funktionen

Observability-Plattformen (DataDog, New Relic, Splunk):

- Metriken zur Anwendungsleistung und Latenz

- Messungen der Fehlerrate und Verfügbarkeit

- Infrastrukturnutzung und Skalierungsmuster

- Benutzererfahrung und Transaktionsverfolgung

Produktanalytik (MixPanel/GA/Amplitude), Cloud-Kostentools

Die Messung der Geschäftsauswirkungen erfordert spezielle Analyse- und Kostenmanagementplattformen, die die technische Bereitstellung mit dem Nutzerverhalten und den finanziellen Ergebnissen verbinden.

Tools zur Produktanalyse:

- Paneel mischen: Event-Tracking und Funnelanalyse zur Einführung von Funktionen

- Amplitude: Analyse der Nutzerreise und Messung der Kundenbindung

- Google Analytics: Web-Traffic und Conversion-Tracking

- Hotjar/Vollständiger Artikel: Aufzeichnung von Benutzersitzungen und Verhaltensanalyse

Cloud-Kostenmanagement:

- AWS Cost Explorer: Detaillierte Kostenaufschlüsselung und Trendanalyse

- Google Cloud-Abrechnung: Ressourcenauslastung und Kostenallokation

- Azure-Kostenmanagement: Empfehlungen zur Budgetverfolgung und -optimierung

- FinOps-Plattformen von Drittanbietern: Multi-Cloud-Kostenoptimierung und Einheitsökonomie

Data Warehouse/BI und Eigentum (zentrale Informationsquelle)

Umfassende Softwaremetriken erfordern eine zentrale Datenerfassung, Transformation und Präsentation. Die Festlegung einer klaren Datenverantwortung verhindert inkonsistente Berichte und ermöglicht eine vertrauenswürdige Entscheidungsfindung.

Komponenten der Datenarchitektur:

- Extrahieren/Transformieren/Laden (ETL): Automatisierte Datenerfassung aus Quellsystemen

- Data-Warehouse: Zentraler Speicher mit konsistenten Schemas und Definitionen

- Geschäftsinformationen: Visualisierungs- und Berichtsebenen für verschiedene Zielgruppen

- Datenverwaltung: Klare Verantwortung, Aktualisierungspläne und Qualitätsüberwachung

Überlegungen zur Implementierung:

- Eine einzige Informationsquelle für jede Kennzahl, um widersprüchliche Berichte zu vermeiden

- Automatisierte Überwachung und Alarmierung der Datenpipeline

- Rollenbasierte Zugriffskontrolle für sensible Leistungsdaten

- Regelmäßige Datenqualitätsaudits und Korrekturverfahren

Letzter Aufruf zum Handeln

Kennzahlen zur Softwareentwicklung stellen einen strategischen Wettbewerbsvorteil dar, wenn sie durchdacht und systematisch umgesetzt werden. Unternehmen, die diese Messungen beherrschen, können schnellere und fundiertere Entscheidungen über Technologieinvestitionen treffen, Risiken durch frühzeitige Problemerkennung reduzieren und klare Zusammenhänge zwischen technischer Arbeit und Geschäftsergebnissen nachweisen.

Der Weg vom Ad-hoc-Engineering-Management zur datengesteuerten Entwicklungsoptimierung erfordert Engagement, geeignete Tools und oft externes Fachwissen, um häufige Fallstricke bei der Implementierung zu vermeiden. Das hier vorgestellte Metrik-Framework bietet CEOs die Grundlage, die sie benötigen, um ihre Softwareentwicklungsorganisationen zu verstehen, zu messen und zu optimieren.

FAQ

Was sind die wichtigsten technischen KPIs für CEOs?

Beginne mit den Vier DORA-Metriken, Vorlaufzeit für Änderungen, Bereitstellungshäufigkeit, Änderungsausfallrate und MTTR. Anschließend fügen Sie Zykluszeit, WIP/Durchsatz, PR-Größe, KPIs für das Kundenerlebnis (absturzfreie Benutzer, p95-Latenz, Core Web Vitals), Sicherheits-SLAs und Wirtschaftlichkeit der FinOps-Einheit (Kosten pro Benutzer/Anforderung/Transaktion) hinzu.

Was sind DORA-Metriken und welche Ziele sollten wir verwenden?

- Vorlaufzeit für Änderungen: begehen → Produktion; Elite < 1 Stunde

- Häufigkeit der Bereitstellung: von On-Demand (Web) bis wöchentlich (mobil/reguliert)

- Ausfallrate ändern: 0— 15% Elite

- MTTR: erholen Sie sich in < 1 Stunde (elitär)

Die Benchmarks variieren je nach Produkttyp und Compliance-Umgebung.

Zykluszeit versus Vorlaufzeit, was ist der Unterschied und warum ist das wichtig?

Vorlaufzeit: Tracks, Commit → Deploy; Zykluszeit umfasst Idee → Bereitstellung, unterteilt in Codierung, Abholung, Überprüfung und Veröffentlichung. Kürzere Zykluszeiten korrelieren mit höherer Qualität und Vorhersagbarkeit. Elite-Teams halten die Gesamtzykluszeit auf ~< 26 Stunden.

Wie verbessern WIP-Grenzwerte den Durchsatz?

von Little's Law (Durchsatz = WIP/Zykluszeit): Durch die Senkung der WIP- und Zykluszeiten wird der Durchsatz erhöht, ohne dass zusätzliche Mitarbeiter hinzukommen. Dadurch werden Kontextwechsel reduziert und Feedback beschleunigt.

Welche PR-Größe bestimmt Qualität und Geschwindigkeit?

Ziel für < 200 STÜCK von PR (elite ~< 85 JAHRE). Übergroße PRs (> 400 LOC) verlangsamen die Reviews, verbergen Fehler und beeinträchtigen die Effizienz des Ablaufs.

.avif)

.avif)